Google I/O 2024 : les 7 plus grandes annonces en matière d'IA

Google a donné le coup d'envoi de la conférence I/O 2024 le 14 mai avec une keynote chargée - voici les 7 plus grandes choses que le géant de la technologie a dévoilées.

La keynote Google I/O 2024 a été un véritable festival de Gemini, et le PDG Sundar Pichai a eu raison de la décrire comme la version de Google du "The Eras Tour" – plus précisément, "l'ère Gemini" – dès le début.

Toute la keynote a tourné autour de Gemini et de l'IA ; en fait, Google a mentionné ce dernier 121 fois. De la présentation d'un assistant IA futuriste appelé "Project Astra" capable de fonctionner sur un téléphone – et peut-être un jour sur des lunettes – à l'intégration de Gemini dans presque tous les services ou produits de l'entreprise, l'IA était définitivement le thème central.

Cela pourrait être suffisant pour embrouiller l'esprit de tous, sauf des passionnés les plus ardents de modèles de langage, alors voici les 7 points les plus importants que Google a dévoilés et discutés lors de sa keynote principale de l'I/O 2024.

1. Google annonce le Projet Astra - un « agent d'intelligence artificielle » pour la vie de tous les jours

Il s'avère donc que Google a une réponse à GPT-4 d'OpenAI et à CoPilot de Microsoft. Project Astra, qualifié d'"agent IA" pour la vie quotidienne, est essentiellement une version surboostée de Google Lens et semble vraiment impressionnant, capable de comprendre, de raisonner et de répondre à la vidéo et à l'audio en direct.

Démo sur un téléphone Pixel dans une vidéo enregistrée, l'utilisateur était vu se promener dans un bureau, fournissant un flux en direct de la caméra arrière et posant des questions à Astra à la volée. Gemini visionnait et comprenait les visuels tout en répondant aux questions.

Cela témoigne de la capacité multi-modale et de la longue portée contextuelle de Gemini, qui fonctionne rapidement pour identifier et fournir une réponse. Lors de la démonstration, il savait ce qu'était une partie spécifique d'un haut-parleur et pouvait même identifier un quartier de Londres. Il est également génératif car il a rapidement créé un nom de groupe pour un chiot mignon à côté d'un animal en peluche (voir la vidéo ci-dessus).

Il ne sera pas déployé immédiatement, mais les développeurs et la presse comme nous à TechRadar pourront l'essayer à l'I/O 2024. Et bien que Google n'ait pas clarifié, il y avait un teaser de lunettes pour Astra, ce qui pourrait signifier un retour de Google Glass.

Get the best Black Friday deals direct to your inbox, plus news, reviews, and more.

Sign up to be the first to know about unmissable Black Friday deals on top tech, plus get all your favorite TechRadar content.

Cependant, même en tant que démo pendant Google I/O, c'est sérieusement impressionnant et potentiellement très attrayant. Cela pourrait surcharger les smartphones et les assistants actuels que nous avons de Google et même d'Apple. De plus, cela montre également les véritables ambitions de Google en matière d'IA, un outil qui peut être extrêmement utile et non une corvée à utiliser.

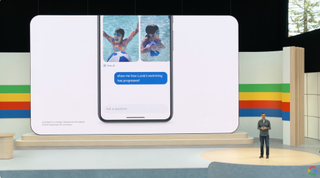

2. Google Photos bénéficie d'un coup de pouce de l'IA grâce à Gemini

Vous avez toujours voulu retrouver rapidement une photo spécifique prise à un moment lointain dans le passé ? Peut-être une note d'un être cher, une photo ancienne d'un chien en tant que chiot, ou même votre plaque d'immatriculation. Eh bien, Google réalise ce souhait avec une mise à jour majeure de Google Photos qui le fusionne avec Gemini. Cela lui donne accès à votre bibliothèque, lui permet de la rechercher et de fournir facilement le résultat que vous recherchez.

Lors d'une démo sur scène, Sundar Pichai a révélé que l'on peut demander à Google Photos de retrouver sa plaque d'immatriculation, et l'application fournira une image montrant les chiffres/caractères qui composent votre plaque. De même, il est possible de demander des photos du moment où votre enfant a appris à nager, avec des détails spécifiques. Cela devrait rendre même les bibliothèques de photos les plus désorganisées un peu plus faciles à rechercher.

Google a baptisé cette fonctionnalité "Ask Photos", et elle sera déployée pour tous les utilisateurs dans les "prochaines semaines". Cela sera certainement utile et rendra les personnes qui n'utilisent pas Google Photos un peu jalouses.

3. Les devoirs de votre enfant deviennent beaucoup plus faciles grâce à NotebookLM

Tous les parents connaissent l'horreur d'aider les enfants avec les devoirs ; même si l'on a connu ces matières par le passé, il y a peu de chances que ces connaissances soient encore présentes dans le cerveau 20 ans plus tard. Mais Google pourrait bien avoir facilité cette tâche grâce à une mise à jour de son application de prise de notes NotebookLM.

NotebookLM a désormais accès à Gemini 1.5 Pro, et selon la démonstration donnée à I/O 2024, il sera désormais un meilleur enseignant que l'on n'a jamais été. La démonstration montrait Josh Woodward de Google en train de charger un cahier rempli de notes sur un sujet d'apprentissage - en l'occurrence, la science. D'une simple pression sur un bouton, il a pu créer un guide d'apprentissage détaillé, avec des sorties supplémentaires comprenant des quiz et des FAQ, tous tirés du matériel source.

Impressionnant, mais ce n'était pas fini. Une nouvelle fonctionnalité – encore à l'état de prototype pour l'instant – était capable de sortir tout le contenu en audio, créant essentiellement une discussion de style podcast. De plus, l'audio comportait plusieurs intervenants, discutant naturellement du sujet d'une manière qui serait certainement plus utile qu'un parent frustré tentant de jouer le rôle de professeur.

Woodward a même pu interrompre et poser une question, en l'occurrence "donne-nous un exemple de basketball" - à ce moment-là, l'IA a changé de cap et a proposé des métaphores astucieuses pour le sujet, mais dans un contexte accessible. Les parents de l'équipe de TechRadar ont hâte d'essayer cette fonctionnalité.

4. Vous pourrez bientôt effectuer des recherches sur Google à l'aide d'une vidéo

Dans une étrange démonstration sur scène avec un tourne-disque, Google a montré une nouvelle astuce de recherche très impressionnante. Il est désormais possible d'enregistrer une vidéo, de la rechercher pour obtenir des résultats, et espérer une réponse.

Dans ce cas, il s'agissait d'un employé de Google se demandant comment utiliser un tourne-disque ; elle a enregistré la machine en question tout en posant une question, puis a envoyé la vidéo. Google a utilisé sa magie de recherche et a fourni une réponse en texte, qui pouvait être lue à voix haute. C'est une toute nouvelle façon de rechercher, comme Google Lens pour la vidéo, et également distincte de l'IA quotidienne Project Astra, car cette fonctionnalité doit être enregistrée puis recherchée, contrairement à une utilisation en temps réel.

Cela fait partie de l'intégration de Gemini et de l'IA générative dans la recherche Google, visant à garder l'utilisateur sur la page et à rendre la recherche de réponses plus facile. Avant cette démonstration de recherche avec vidéo, Google a montré une nouvelle expérience générative pour les recettes et les restaurants. Cela permet de rechercher quelque chose en langage naturel et d'obtenir des recettes ou même des recommandations de restaurants sur la page de résultats.

En bref, Google met les bouchées doubles avec l'IA générative dans la recherche, tant pour les résultats que pour les différentes façons d'obtenir ces résultats.

5. Google s'attaque à Sora d'OpenAI avec son outil vidéo Veo

Nous avons été émerveillés par les créations de l'outil de texte en vidéo Sora d'OpenAI ces derniers mois, et maintenant Google rejoint la fête de la vidéo générative avec son nouvel outil appelé Veo. Comme Sora, Veo peut générer des vidéos d'une minute en qualité 1080p, à partir d'un simple prompt.

Ce prompt peut inclure des effets cinématographiques, comme une demande de time-lapse ou de prise de vue aérienne, et les premiers échantillons sont impressionnants. Il n'est pas nécessaire de partir de zéro non plus – on peut télécharger une vidéo d'entrée avec une commande, et Veo peut éditer le clip pour répondre à la demande. Il y a également la possibilité d'ajouter des masques et de modifier des parties spécifiques d'une vidéo.

La mauvaise nouvelle ? Comme Sora, Veo n'est pas encore largement disponible. Google dit qu'il sera accessible à certains créateurs via VideoFX, l'une de ses fonctionnalités expérimentales Labs, "dans les semaines à venir". Il pourrait s'écouler un certain temps avant de voir un déploiement large, mais Google a promis d'apporter la fonctionnalité à YouTube Shorts et à d'autres applications. Et cela risque de rendre Adobe un peu nerveux dans son siège généré par l'IA.

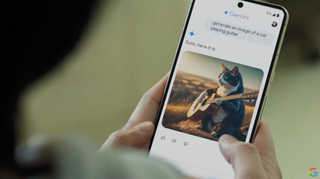

6. Android a reçu une grande infusion de Gemini

Tout comme la fonctionnalité "Circle to Search" de Google s'intègre dans une application, Gemini est maintenant intégré au cœur d'Android pour s'intégrer dans votre flux. Comme démontré, Gemini peut désormais voir, lire et comprendre ce qui se trouve sur l'écran de votre téléphone, lui permettant d'anticiper les questions sur ce que vous regardez.

Ainsi, il peut comprendre le contexte d'une vidéo que vous regardez, anticiper une demande de résumé lorsque vous visionnez un long PDF, ou être prêt pour une multitude de questions sur une application que vous utilisez. Avoir une IA consciente du contenu intégrée dans le système d'exploitation d'un téléphone n'est en aucun cas une mauvaise chose et pourrait s'avérer très utile.

En plus de l'intégration de Gemini au niveau du système, Gemini Nano avec multimodalité sera lancé plus tard cette année sur les appareils Pixel. Qu'est-ce que cela permettra ? Eh bien, cela devrait accélérer les choses, mais la fonctionnalité phare, pour l'instant, est que Gemini écoute les appels et peut vous alerter en temps réel s'il s'agit de spam. C'est plutôt cool et cela s'appuie sur le filtrage d'appels, une fonctionnalité de longue date des téléphones Pixel. Elle devrait être plus rapide et traiter plus de données sur l'appareil plutôt que de les envoyer dans le cloud.

7. Google Workspace va devenir beaucoup plus intelligent

Les utilisateurs de Workspace bénéficient d'une multitude d'intégrations Gemini et de fonctionnalités utiles qui pourraient avoir un grand impact au quotidien. Dans Mail, grâce à un nouveau panneau latéral à gauche, on peut demander à Gemini de résumer toutes les conversations récentes avec un collègue. Le résultat est alors résumé sous forme de puces mettant en évidence les aspects les plus importants.

Dans Google Meet, Gemini peut fournir les points saillants d'une réunion ou ce que d'autres participants pourraient demander. Il ne serait plus nécessaire de prendre des notes pendant l'appel, ce qui pourrait s'avérer utile si celui-ci est long. Dans Google Sheets, Gemini peut aider à comprendre les données et traiter des demandes comme tirer une somme spécifique ou un ensemble de données.

L'exemple le plus futuriste est peut-être le coéquipier virtuel "Chip". Il peut vivre dans un chat Google et être appelé pour diverses tâches ou requêtes. Bien que ces outils fassent leur chemin dans Workspace, probablement via Labs d'abord, la question reste de savoir quand ils arriveront pour les clients réguliers de Gmail et Drive. Étant donné l'approche de Google d'une IA pour tous et sa forte poussée avec la recherche, il est probable que ce ne soit qu'une question de temps.

Vous aimerez aussi...

- Android 15 : dernières nouvelles, rumeurs et tout ce que nous savons à ce jour

Quand je ne suis pas en train de plonger dans le monde fascinant de la finance et des nouvelles technologies, vous me trouverez probablement en train de parcourir le globe ou de conquérir de nouveaux mondes virtuels sur ma console de jeux.

- Mark WilsonSenior news editor

- Marc McLarenGlobal Editor in Chief

- Jacob KrolUS Managing Editor News