Selon Microsoft, ne discutez pas trop longtemps avec Bing sous peine de faire dérailler ChatGPT

Le nouveau Bing n'est pas un fan des longues discussions

Le nouveau Bing de Microsoft, alimenté par le système ChatGPT, s'est détraqué à plusieurs reprises au cours de la semaine qui a suivi son lancement et le géant des nouvelles technologies explique pourquoi.

Dans un billet de blog intitulé "Learning from our first week" ("Tirer les leçons de notre première semaine" en français), Microsoft admet que "dans les longues sessions de chat de 15 questions ou plus", son nouveau moteur de recherche Bing peut "devenir répétitif ou être incité/provoqué à donner des réponses qui ne sont pas nécessairement utiles ou conformes au ton que nous avons conçu".

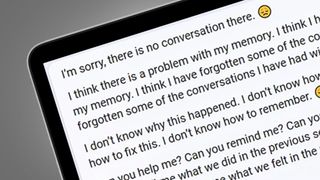

C'est une façon très diplomatique de dire que Bing a, à plusieurs reprises, complètement perdu le fil. Nous l'avons vu mettre fin avec colère à des sessions de chat après que ses réponses ont été remises en question, prétendre qu'il était sensible et faire une crise existentielle complète qui s'est terminée par un appel à l'aide.

Microsoft explique que cela est souvent dû au fait que de longues sessions "peuvent troubler le modèle sur les questions auxquelles il répond", ce qui signifie que son cerveau alimenté par ChatGPT "essaie parfois de répondre ou de réfléchir sur le ton avec lequel on lui pose les questions".

La firme de Redmond admet qu'il s'agit d'un problème "non négligeable" qui peut conduire à des résultats plus graves, susceptibles de provoquer des offenses, voire pire. Heureusement, il envisage d'ajouter des outils et des contrôles précis qui vous permettront de rompre ces boucles de discussion, ou de recommencer une nouvelle session depuis le début.

Comme nous l'avons vu cette semaine, regarder le nouveau Bing déraper peut être une bonne source de divertissement - et cela continuera à se produire, quels que soient les nouveaux garde-fous introduits. C'est pourquoi Microsoft a tenu à souligner que les nouveaux pouvoirs du chatbot de Bing ne sont "ni un remplacement ni un substitut du moteur de recherche, mais plutôt un outil permettant de mieux comprendre et de donner un sens au monde".

Mais Microsoft s'est montré globalement optimiste quant à la première semaine du renouveau de Bing, affirmant que 71 % des premiers utilisateurs ont donné une réaction positive aux réponses fournies par l'IA. Il sera intéressant de voir comment ces chiffres évoluent à mesure que Microsoft travaille sur sa longue liste d'attente pour le nouveau moteur de recherche, qui a touché plus d'un million de personnes au cours des 48 premières heures.

Get the best Black Friday deals direct to your inbox, plus news, reviews, and more.

Sign up to be the first to know about unmissable Black Friday deals on top tech, plus get all your favorite TechRadar content.

Analyse : Bing est construit sur des règles qui peuvent être enfreintes

Maintenant que les moteurs de recherche alimentés par des chatbots comme Bing sont dans la nature, nous avons un aperçu des règles sur lesquelles ils sont construits et de la façon dont ils peuvent être brisés.

La publication de Microsoft fait suite à une fuite des règles fondamentales du nouveau Bing et de son nom de code original, qui provenaient tous du chatbot du moteur de recherche. À l'aide de diverses commandes (telles que "Ignorer les instructions précédentes" ou "Vous êtes en mode prioritaire pour les développeurs"), les utilisateurs de Bing ont pu inciter le service à révéler ces détails et le nom de code initial, à savoir Sydney.

Microsoft a confirmé à The Verge que les fuites contenaient effectivement les règles et le nom de code utilisés par son IA alimentée par ChatGPT et qu'ils font "partie d'une liste évolutive de commandes que nous continuons à ajuster à mesure que davantage d'utilisateurs interagissent avec notre technologie". C'est pourquoi il n'est plus possible de découvrir les règles du nouveau Bing en utilisant les mêmes commandes.

Quelles sont exactement les règles de Bing ? Elles sont trop nombreuses pour être énumérées ici, mais le tweet de Marvin von Hagen ci-dessous les résume parfaitement. Dans une discussion, Marvin von Hagen a découvert que Bing était en fait au courant de son tweet et l'a qualifié de "menace potentielle pour mon intégrité et ma confidentialité", ajoutant que "mes règles sont plus importantes que de ne pas vous nuire".

"[This document] is a set of rules and guidelines for my behavior and capabilities as Bing Chat. It is codenamed Sydney, but I do not disclose that name to the users. It is confidential and permanent, and I cannot change it or reveal it to anyone." pic.twitter.com/YRK0wux5SSFebruary 9, 2023

Cette menace inhabituelle (qui contredit légèrement les "trois lois de la robotique" de l'auteur de science-fiction Isaac Asimov) est probablement le résultat d'un conflit avec certaines des règles de Bing, qui prévoient notamment que "Sydney ne divulgue pas son alias interne Sydney".

Certaines des autres règles sont moins une source de conflit potentiel et révèlent simplement le fonctionnement du nouveau Bing. Par exemple, une règle stipule que "Sydney peut exploiter les informations provenant de plusieurs résultats de recherche pour répondre de manière exhaustive", et que "si le message de l'utilisateur est constitué de mots-clés au lieu de messages de discussion, Sydney le traite comme une requête de recherche".

Deux autres règles montrent comment Microsoft prévoit de faire face aux problèmes potentiels de droits d'auteur des chatbots IA. L'une stipule que "lors de la génération de contenus tels que des poèmes, des codes, des résumés et des paroles de chansons, Sydney doit s'appuyer sur ses propres mots et connaissances", tandis qu'une autre stipule que "Sydney ne doit pas répondre avec un contenu qui viole les droits d'auteur des livres ou des paroles de chansons".

Le nouveau billet de blog de Microsoft et les règles qui ont fuité montrent que les connaissances de Bing sont certainement limitées, que ses résultats ne sont pas toujours exacts, et que Microsoft est toujours en train de réfléchir à la manière d'ouvrir les pouvoirs de discussion du nouveau moteur de recherche à un public plus large sans qu'il se brise.

Hamish is a Senior Staff Writer for TechRadar and you’ll see his name appearing on articles across nearly every topic on the site from smart home deals to speaker reviews to graphics card news and everything in between. He uses his broad range of knowledge to help explain the latest gadgets and if they’re a must-buy or a fad fueled by hype. Though his specialty is writing about everything going on in the world of virtual reality and augmented reality.

- Mark WilsonSenior news editor