Nvidia annonserer Turing-arkitekturen og GPU-er laget for ray-tracing

Møt den nye Quadro RTX-familien

Det har lenge gått rykter om Nvidias GPU-arkitektur Turing, forventet brukt i nestegenerasjonsgrafikkort fra brikkeprodusenten, og nå er den endelig offisiell, og er mer imponerende enn tidligere antatt.

Turing kombinerer en rekke nye egenskaper og teknologier, der hovedattraksjonen er de nye såkalte RT-kjernene, som prosesserer ray tracing i sanntid. Disse spesialiserte kjernene regner ut hvordan lys og lyd beveger seg i et 3D-rom, og gjør dette i en hastighet på 10 GigaRays.

Det ovennevnte høres kanskje ut som en måleenhet Nvidia har funnet på på sparket, men det hevdes altså at Turing kan prosessere ray tracing i sanntid 25 ganger raskere enn Pascal-arkitekturen. Teknologi-selskapet bemerket også at GPU-nodene de leverer kan levere 30 ganger bedre ytelse enn en CPU-node når brukt til såkalt final-frame rendering av filmeffekter.

I tillegg til denne spesialiserte ray tracing-teknologien har Nvidia integrert Tensor-kjernene kjent fra Volta-baserte GPU-er, slik at også AI og maskinlæringsytelse får seg en opptur. Disse Tensor-kjernene vil kunne levere opptil 500 trillioner tensoroperasjoner per sekund, og dermed aksellesere eksempelvis hierarkisk læring («deep learning»).

AI kommer på sin side til å hjelpe med nye metoder å rendre bilder på, slik som «deep learning anti-aliasing», altså en ny form for kantutjevning, som lover høykvalitetsrendring av bilder i samspill med støyreduksjon, skalering av oppløsning og re-timing av video.

En helt ny verden innen grafikk

Nvidia Turing kommer til å kombinere både RT- og Tensor-kjernene i en ny form for hybridrendring som inkluderer både simulering og bedre raster-teknikk. Det amerikanske teknologiselskapet annonserte at denne teknologien først kommer til å være et hjelpemiddel i medieproduksjon i VFX-industrien, der man lage interaktive opplevelser med filmatiske kvaliteter.

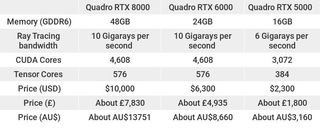

For å få til dette har Nvidia introdusert tre nye Quadro RTX-kort som har opptil 48 GB GDDR6-minne, 4608 CUDA-kjerner og 576 Tensor-kjerner, alt bygget på Turing-arkitekturen.

Få daglig innsikt, inspirasjon og tilbud i innboksen din

Registrer deg for siste nytt, anmeldelser, meninger, toppteknologiske tilbud og mer.

Selv om Nvidia ikke nevnte Turing-baserte GeForce-grafikkort denne gangen, så er dette den klareste indikasjonen vi har fått hittil på hvordan spesifikasjonene til GeForce-kortene kommer til å fortone seg. Vi er ganske sikre på at vi kommer til å se Nvidia GeForce RTX 2080 eller Nvidia GeForce GTX 1180 før måneden er omme.

Kevin Lee was a former computing reporter at TechRadar. Kevin is now the SEO Updates Editor at IGN based in New York. He handles all of the best of tech buying guides while also dipping his hand in the entertainment and games evergreen content. Kevin has over eight years of experience in the tech and games publications with previous bylines at Polygon, PC World, and more. Outside of work, Kevin is major movie buff of cult and bad films. He also regularly plays flight & space sim and racing games. IRL he's a fan of archery, axe throwing, and board games.