Basta allarmismo: ChatGPT non è veramente intelligente

Una vera e propria intelligenza artificiale sarà un giorno possibile, ma non è ChatGPT

Alan Turing (1912-1954), uno dei pionieri dell'informatica, verso la fine della sua tragica breve vita era ossessionato dall'intelligenza artificiale a tal punto che ha ideato un test non ufficiale per stabilire quando un computer può essere considerato veramente intelligente come un essere umano, quello che oggi chiamiamo il Test di Turing.

Il test è piuttosto semplice. Chiedete a qualcuno di comunicare con un computer e se non è in grado di capire che sta parlando con un computer, cioè se è indistinguibile da un umano a un altro umano, allora il software più essere considerato intelligente a livello di un cervello organico.

Ebbene, ChatGPT sembra superare questo test a pieni voti. Infatti, non solo supera il test di Turing, ma supera anche gli esami della facoltà di medicina e di legge e fa i compiti. Tutti ciò ci porta a proiettare su ChatGPT, e sull'intelligenza artificiale generativa in generale, qualità e caratteristiche umane che in realtà non ha.

Normalmente, questo non sarebbe un grosso problema. Le persone fraintendono continuamente ogni genere di cose, ma poiché le IA simili a ChatGPT si diffonderanno sempre di più nei prossimi mesi, le persone attribuiranno loro caratteristiche che in realtà non hanno.

Che cos'è una Rete Generativa Avversaria?

La tecnologia alla base di ChatGPT, Stable Diffusion, e di tutte le altre IA che producono immagini, testi, musica e altro ancora è la cosiddetta Rete Generativa Avversaria (GAN). Essenzialmente, una GAN è costituita da due sistemi software che lavorano insieme. Uno produce un output, il generatore, e l'altro, il classificatore, determina se i dati sono validi o meno.

Il generatore e il classificatore di una GAN si muovono parola per parola o pixel per pixel e si confrontano per produrre un consenso prima di passare al segmento successivo. Un po' alla volta (letteralmente), una GAN produce un risultato che replica molto da vicino quello che può fare un essere umano, in modo creativo.

Il generatore si affida a una quantità impressionante di dati di input che "addestra" per produrre i suoi output, mentre il classificatore si affida ai propri input per determinare se ciò che il generatore ha prodotto ha senso. Questo può essere o non essere il modo in cui l'intelligenza umana "crea" nuove cose, i neurologi stanno ancora cercando di capirlo, ma in molti modi si può riconoscere l'albero dai frutti che produce.

Ricevi approfondimenti quotidiani, ispirazione e offerte nella tua casella di posta

Iscriviti per ricevere ultime notizie, recensioni, opinioni, offerte tecnologiche e altro ancora.

Perché il test di Turing non è più affidabile?

Il fatto che ChatGPT superi il test di Turing non significa che ChatGPT sia intelligente quanto un essere umano. È chiaro che non lo è. Tutto ciò significa che il test di Turing non è il test valido per l'intelligenza artificiale che pensavamo fosse.

Quando Turing ideò il suo test per l'intelligenza artificiale, intendeva conversare con un attore razionale in modo tale che non si potesse dire che si stava parlando con una macchina. È implicita l'idea che la macchina capisca ciò che si sta dicendo. Tutto ciò è molto diverso dal riconoscimento di parole chiave e generazione di una risposta probabilistica a una lunga serie di input.

Per Turing, conversare con una macchina al punto da renderla indistinguibile da un essere umano rifletteva l'intelligenza, perché creare un vasto archivio di parole con diversi valori assegnati a ciascuna di esse a seconda delle parole che la precedono in una frase era qualcosa che nessuno avrebbe potuto concepire all'epoca.

Il tipo di matematica richiesta per questo compito su macchine che impiegavano un'intera giornata per eseguire calcoli che il più economico smartphone può fare in un nanosecondo, sarebbe sembrata impraticabile come contare il numero di atomi nell'universo. Non sarebbe stato nemmeno preso in considerazione all'epoca.

Sfortunatamente, Turing non visse abbastanza a lungo da prevedere l'ascesa della scienza dei dati e dei chatbot, e nemmeno il circuito integrato che alimenta i computer moderni. Anche prima di ChatGPT, i chatbot erano sulla buona strada per superare il test di Turing come comunemente inteso, come può dirvi chiunque usi un chatbot per parlare con la propria banca. Ma Turing non avrebbe considerato un chatbot come una mente artificiale pari a quella umana.

Un chatbot è uno strumento monouso, non un'intelligenza. Un'intelligenza di livello umano richiede la capacità di andare oltre i parametri stabiliti dai suoi sviluppatori, di propria volontà. ChatGPT è preterintenzionalmente abile nell'imitare i modelli di linguaggio umano, ma lo è anche un pappagallo, e nessuno può sostenere che un pappagallo capisca il significato dietro le parole che sta ripetendo.

ChatGPT non impara autonomamente

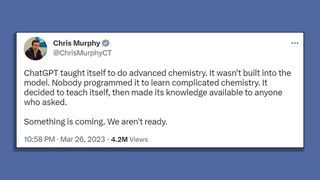

Questa settimana, il senatore statunitense Chris Murphy ha dichiarato su Twitter che ChatGPT ha imparato da solo la chimica, senza essere sollecitato dai suoi creatori. A meno che il senatore Murphy non sappia qualcosa che non è stato reso pubblico, ChatGPT come lo conosciamo non può fare una cosa del genere.

Per essere chiari, se ChatGPT o qualsiasi altra GAN cercasse e imparasse qualcosa di propria iniziativa, allora siamo davvero entrati nel mondo post-umano dell'Intelligenza Generale Artificiale, poiché la dimostrazione di un'iniziativa indipendente sarebbe indiscutibilmente un indicatore di intelligenza. Ma se uno sviluppatore dice a un bot di andare a imparare qualcosa e il bot fa quello che gli viene chiesto, questo non rende il bot intelligente.

Fare ciò che viene detto e fare qualcosa di propria volontà possono sembrare simili a un osservatore esterno, ma sono due cose molto diverse. Gli esseri umani lo capiscono intuitivamente ma, per esempio, ChatGPT può spiegarci questa differenza solo se gli sono stati forniti testi di filosofia che trattano il tema del libero arbitrio. Se non gli sono mai stati dati in pasto Platone, Aristotele o Nietzsche, non riuscirà a trovare da solo l'idea del libero arbitrio. Non saprà nemmeno che esiste, se non gli viene detto che esiste.

A cosa dovremmo prestare attenzione?

Abbiamo parlato a lungo dei pericoli di ChatGPT, soprattutto del fatto che non è in grado di capire ciò che dice e quindi può produrre informazioni errate diffamatorie o plagiate.

Tuttavia, c'è un problema più famoso: ChatGPT viene visto come un sostituto dei lavoratori umani, poiché sembra proprio che ChatGPT, Stable Diffusion, e altre IA generative possano fare ciò che gli esseri umani possono fare più rapidamente, più facilmente e a un prezzo molto più basso. Questa è una discussione per un'altra volta, ma le conseguenze sociali di ChatGPT sono probabilmente il pericolo maggiore.

ChatGPT, nella sua essenza, è un sistema di nodi digitali collegati tra loro con medie assegnate a ciascuno di essi che producono un output logico dato un input. Questo non è pensiero, è letteralmente solo matematica programmata dagli esseri umani in una macchina. Può sembrare potente, ma le menti umane che l'hanno creata sono la vera intelligenza e non vanno confuse.

- John LoefflerComponents Editor

Più popolari