Molti credono che l'intelligenza artificiale sia cosciente come una persona

Il 67% considera ChatGPT e altri strumenti di intelligenza artificiale come consapevoli

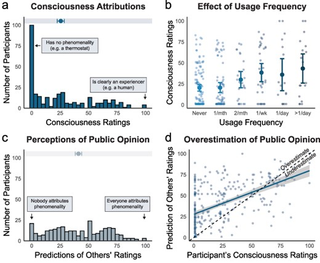

Quando si interagisce con ChatGPT e altri strumenti di IA generativa conversazionale, questi elaborano i vostri input attraverso algoritmi per comporre una risposta che può sembrare provenire da un essere senziente, nonostante la realtà del funzionamento dei grandi modelli linguistici (LLM). Due terzi degli intervistati per , uno studio dell'Università di Waterloo, ritengono comunque che i chatbot AI siano in qualche modo coscienti, superando il test di Turing per convincerli che un'AI è equivalente a un essere umano in termini di coscienza.

L'IA generativa, incarnata dal lavoro di OpenAI su ChatGPT, ha fatto passi da gigante negli ultimi anni. L'azienda e i suoi rivali parlano spesso di una visione dell'intelligenza artificiale generale (AGI) con un'intelligenza simile a quella umana. OpenAI ha persino una nuova scala per misurare quanto i loro modelli siano vicini a raggiungere l'AGI. Tuttavia, anche gli esperti più ottimisti non ritengono che i sistemi AGI saranno autocoscienti o capaci di vere emozioni. Tuttavia, delle 300 persone che hanno partecipato allo studio, il 67% ha dichiarato di credere che il ChatGPT possa ragionare, provare emozioni ed essere in qualche modo consapevole della propria esistenza.

È emersa anche una notevole correlazione tra la frequenza di utilizzo degli strumenti di intelligenza artificiale e la probabilità di percepire la coscienza al loro interno. Questo testimonia quanto ChatGPT sia bravo a imitare gli esseri umani, ma non significa che l'IA si sia risvegliata. L'approccio conversazionale di ChatGPT probabilmente la fa sembrare più umana, anche se nessun modello di IA funziona come un cervello umano. E anche se OpenAI sta lavorando a un modello di IA in grado di svolgere ricerche in modo autonomo chiamato Strawberry, questo è ancora diverso da un'IA consapevole di ciò che sta facendo e perché.

"Mentre la maggior parte degli esperti nega che le attuali IA possano essere coscienti, la nostra ricerca dimostra che per la maggior parte del pubblico la coscienza delle IA è già una realtà", ha spiegato Clara Colombatto, docente di psicologia dell'Università di Waterloo e co-conduttrice dello studio. "Questi risultati dimostrano il potere del linguaggio, perché una conversazione da sola può portarci a pensare che un agente che ha un aspetto e un funzionamento molto diverso dal nostro possa avere una mente".

Disservizio al cliente

La convinzione della coscienza dell'IA potrebbe avere importanti implicazioni sul modo in cui le persone interagiscono con gli strumenti di IA. Il lato positivo è che incoraggia le buone maniere e rende più facile fidarsi di ciò che fanno gli strumenti, il che potrebbe renderli più facili da integrare nella vita quotidiana. Ma la fiducia comporta dei rischi, che vanno da un'eccessiva dipendenza da questi strumenti per il processo decisionale fino, all'estremo, a una dipendenza emotiva dall'IA e a una riduzione delle interazioni umane.

I ricercatori intendono approfondire i fattori specifici che inducono le persone a pensare che l'IA abbia una coscienza e che cosa questo significhi a livello individuale e sociale. Verrà inoltre effettuato uno studio a lungo termine su come questi atteggiamenti cambiano nel tempo e in base al background culturale. Comprendere la percezione pubblica della coscienza dell'IA è fondamentale non solo per lo sviluppo di prodotti di IA, ma anche per i regolamenti e le norme che ne disciplinano l'uso.

"Oltre alle emozioni, la coscienza è legata alle capacità intellettuali che sono essenziali per la responsabilità morale: la capacità di formulare piani, di agire intenzionalmente e di avere un autocontrollo sono elementi fondamentali dei nostri sistemi etici e legali", ha detto Colombatto. "Questi atteggiamenti pubblici dovrebbero quindi essere una considerazione chiave nella progettazione e nella regolamentazione dell'IA per un uso sicuro, insieme al consenso degli esperti".

Get the best Black Friday deals direct to your inbox, plus news, reviews, and more.

Sign up to be the first to know about unmissable Black Friday deals on top tech, plus get all your favorite TechRadar content.

Leggi anche

- OpenAI ha una nuova scala per misurare l'intelligenza dei suoi modelli AI, che non è così confortante come dovrebbe essere

- Un sondaggio rivela che la maggior parte delle persone preferirebbe cambiare azienda piuttosto che avere a che fare con il servizio clienti dell'IA

- OpenAI potrebbe essere al lavoro su un'IA in grado di eseguire ricerche senza l'aiuto umano - il che dovrebbe andare bene

Eric Hal Schwartz is a freelance writer for TechRadar with more than 15 years of experience covering the intersection of the world and technology. For the last five years, he served as head writer for Voicebot.ai and was on the leading edge of reporting on generative AI and large language models. He's since become an expert on the products of generative AI models, such as OpenAI’s ChatGPT, Anthropic’s Claude, Google Gemini, and every other synthetic media tool. His experience runs the gamut of media, including print, digital, broadcast, and live events. Now, he's continuing to tell the stories people want and need to hear about the rapidly evolving AI space and its impact on their lives. Eric is based in New York City.