Pentium 4 Prescott e NetBurst, quando i processori Intel correvano nel fuoco

Ripercorriamo la storia dei Pentium 4 e dell'architettura NetBurst di Intel, scoprendo i motivi dietro il suo fallimento tecnico.

Alla fine degli anni ’90, lo sviluppo dell’informatica così come la conosciamo era nel pieno della sua corsa. I processori si apprestavano a raggiungere e abbattere il muro dei 1000 MHz o 1 GHz, all’epoca considerata una frequenza stratosferica, con Intel che stava preparando il successore della sua architettura P6, alla base dei modelli più storici come il Pentium Pro, il Pentium II e il Pentium III.

Durante quel periodo, ben più di quanto avviene oggi, la frequenza era un fattore che aveva un ammiccamento molto importante tra il pubblico. Era un elemento preponderante che faceva pendere l’ago della bilancia sul modello più veloce durante l’acquisto di un PC. Anche durante le conversazioni tra conoscenti, la domanda più gettonata riguardava la frequenza della propria CPU.

Si posero le basi per quello che venne definita "la corsa al GHz", che tuttavia si arresterà ben prima degli obiettivi originari di Intel per via dei problemi tecnici che si presentarono poco dopo. Ciò fu anche causato dai processi produttivi utilizzati in quel periodo, decisamente poco maturi per ambizioni che, tutt'ora, risulterebbero decisamente esagerate.

A ogni modo, nel 1999 Intel finì di sviluppare NetBurst, l'architettura alla base di tutti i Pentium 4.

Pipeline, salti e predizione delle diramazioni: questi sconosciuti

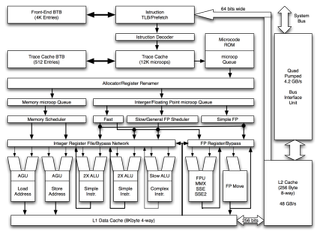

Prima di addentrarci sui tecnicismi, è però opportuno spiegare cos'è e come funziona una pipeline per CPU: si tratta di una soluzione pensata per incrementare la quantità di operazioni eseguite in un determinato periodo di tempo, parallelizzandone i flussi e l'elaborazione.

Dobbiamo immaginare il processore come una vera e propria catena di montaggio: ogni stadio della coda di calcolo si occupa di svolgere sequenzialmente uno specifico compito relativo a una determinata istruzione. Quando la coda di calcolo funziona a regime, l'ultimo stadio di questa produce un'istruzione completa per ogni ciclo di clock concluso, nello stesso istante in cui altre unità stanno effettuando in parallelo operazioni analoghe.

Uno dei problemi legati alle pipeline sono i cosiddetti "salti", nello specifico i "salti condizionati". I salti, o diramazioni, sono dei punti in cui viene alterato il flusso sequenziale delle istruzioni a seguito di un comando: ciò avviene per via di un'istruzione specifica e serve a mandare in esecuzione un altra parte di codice indicata nell'istruzione del salto. Quando questo accade, la CPU è costretta a svuotare la coda di calcolo per caricare ed eseguire il nuovo flusso di istruzioni.

Get the best Black Friday deals direct to your inbox, plus news, reviews, and more.

Sign up to be the first to know about unmissable Black Friday deals on top tech, plus get all your favorite TechRadar content.

Lo svuotamento della cache e il caricamento di nuovi compiti da eseguire causa la perdita di diversi cicli di clock e, se l'architettura non è particolarmente efficiente da questo punto di vista, come nel caso del Pentium 4, può impattare molto negativamente sull'IPC.

Per prevenire e limitare la perdita di prestazioni che ne consegue, uno dei metodi da tempo utilizzati sui processori è la cosiddetta predizione delle diramazioni, che ha anche un'unità dedicata all'interno della CPU, ovvero la Branch Prediction Unit: questa si occupa di prevedere l'esito dell'istruzione su cui è basata l'accettazione del salto, evitando così i rallentamenti causati dai cicli di clock sprecati per lo svuotamento della pipeline.

Intel e NetBurst: obiettivo frequenze alte

Con lo sviluppo di NetBurst, le frequenze elevate diventarono il nuovo obiettivo di Intel che, ormai più di 20 anni fa, decise di fare leva su questo fattore allo scopo di riscuotere successo tra il pubblico con i suoi Pentium 4. Contrariamente a quanto si potrebbe pensare, la frequenza operativa non rappresenta il fattore principale su cui sviluppare un’architettura per CPU, dove invece altre caratteristiche importanti, come l’IPC (Istruction Per Clock – o Istruzioni Per Ciclo di Clock) e l’efficienza energetica, la fanno da padrona.

L'azienda di Santa Clara decise però di abbandonare questo paradigma, per dare priorità alle alte frequenze, all'epoca del tutto fantascientifiche, e alla velocità di esecuzione. Per assecondare questa richiesta, la divisione ingegneristica dell'azienda fu così costretta a intervenire in determinati aspetti tecnici dell'architettura, come la pipeline e l'introduzione di alcune tecnologie, che rappresentano i punti cardine su cui si basa il funzionamento del Pentium 4.

Al fine di assicurare la massima stabilità possibile per via dell'adozione di frequenze di funzionamento molto spinte, oltre a parallelizzare maggiormente l'esecuzione delle operazioni, l'architettura NetBurst adotta innanzitutto una pipeline particolarmente lunga: si partirà con 20 stadi sui primi processori Willamette e sui successivi Northwood, finendo con ben 31 stadi sui Prescott, allo scopo di facilitare il raggiungimento di clock particolarmente spinti.

Come spiegato nel precedente paragrafo, i risvolti negativi di questa scelta progettuale impattano fortemente sull'IPC, aspetto che tuttavia, secondo Intel stessa, doveva essere mitigato dal raggiungimento di frequenze molto alte, operazione particolarmente agevolata proprio dalla lunga pipeline.

Per mitigare ulteriormente il calo di IPC, il Rapid Execution Engine prevedeva invece l'aggiunta ulteriori due unità destinate alle operazioni sugli interi all'interno dell'ALU (Arithmetic Logic Unit), che opera inoltre al doppio della frequenza operativa della CPU: se il clock del modello era, ad esempio, di 3 GHz, quello dell'ALU raggiungeva i 6 GHz.

Execution Trace Cache permetteva infine di velocizzare il prelievo e la decodifica di istruzioni da parte della CPU, consentendo l'accesso diretto alle micro-operazioni che risedevano nella cosiddetta trace cache, una memoria che contiene tracce di istruzioni già immagazzinate. Queste mantenevano anche l'ordine di esecuzione già previsto tramite algoritmi, facendo ulteriormente risparmiare tempo nelle operazioni.

Le ambizioni di Intel e le varianti commercializzate

Il Pentium 4 fu realizzato nelle varianti Willamette, Northwood, Prescott e Cedar Mill. Intel prevedeva di raggiungere frequenze ancora più alte nel corso del decennio, nell'ordine di ben 10GHz, ambizioni a dir poco pretenziose per i processi produttivi dell’epoca (si stava appena passando dai 120nm ai 90nm, per arrivare ai 65nm negli ultimi modelli).

Willamette

I primi Pentium 4 Willamette debuttarono nel 2000 dopo alcuni ritardi per via della progettazione ancora incompleta, motivo per cui venne definito da molti esperti e addetti ai lavori un effettivo "tappabuchi". Nonostante la frequenza di 1.3GHz, questi modelli erano infatti più lenti delle ultime versioni di Pentium III Tualatin a parità di clock, ma anche delle proposte concorrenti di AMD, che già allora ponevano l'accento sull'efficienza computazionale ed energetica.

Willamette mise probabilmente alla luce le criticità più evidenti del progetto, per cui Intel fu costretta a porre rimedio con Northwood.

Northwood

La seconda iterazione dei Pentium 4 migliorava sostanzialmente l'architettura, tirando fuori molte più performance da NetBurst: innanzitutto si passava dal socket PGA423 a quello da 478 contatti (PGA478), oltre a un processo produttivo più piccolo, 130nm rispetto dai 180nm di Willamette, il che permise subito di abbattere sia consumi che temperature.

Con Northwood raddoppiò anche la cache L2, che passava da 256KB a 512KB, oltre a una FPU notevolmente migliorata e il supporto alle memorie RAM DDR (Double Data Rate) che oggi tutti ormai conosciamo. Le prime versioni di questa variante continuavano a usare il front side bus Quad Pumped da 400MHz (100MHz x 4), mentre le successive aumentarono la frequenza a 533MHz (133MHz x 4).

Questa fu probabilmente la miglior variante commercializzata, prodotta velocemente in diversi tagli caratterizzati da frequenze man mano sempre più alte, che superarono la soglia dei 3GHz per raggiungere un clock massimo di 3,4GHz. Una delle novità maggiori introdotte con Northwood, tornata poi (per restare) in tempi più recenti, fu la tecnologia Hyper Threading, con cui era possibile eseguire due thread simultaneamente, facendo comparire al sistema operativo la CPU come un "dual-core virtuale" attraverso la duplicazione di alcune unità del core e l'utilizzo di tecniche di multithreading. Le ultime versioni facevano inoltre uso di BUS Quad Pumped da 800MHz (200MHz x 4).

Anche se la tecnologia HT non si rivelò particolarmente efficace come lo è ormai oggi, Northwood fu la variante più efficiente sotto il punto di vista computazionale: non scaldava ed era capace di competere abbastanza bene con i processori Athlon.

Prescott

Seguendo il paradigma dell'aumento progressivo delle frequenze, che avrebbero dovuto raggiungere valori sempre più elevati nelle successive versioni, Intel commercializzò Prescott nel 2004. Questa variante specifica segna tuttavia la battuta d'arresto effettiva di NetBurst poiché, nonostante le migliorie rispetto a Northwood, vennero ancora una volta fuori le problematiche tecniche dell'architettura.

Con Prescott venne introdotto il processo produttivo a 90nm, che permise a Intel di migliorare la resa produttiva. La cache L2 raddoppiò ancora una volta, portandosi a 1MB, per salire ulteriormente a 2MB nella serie 6xx, stessa cosa per la cache L1 che da 8KB salì a 16KB.

Le note negative iniziano però da subito con la pipeline, che stavolta aumenta la lunghezza a ben 31 stadi, peggiorando ancor di più lo spreco di cicli di clock in caso si fossero verificati dei salti. Ciò era tuttavia previsto in funzione di un teorico obiettivo nel raggiungere frequenze di funzionamento fino a ben 5GHz; ancora una volta, ambizioni più che ottimistiche.

A ciò si aggiunsero anche dei problemi di surriscaldamento, dovuti al consumo massimo di ben 130W, il che costrinse molti acquirenti a sostituire il dissipatore di fabbrica fornito con il processore, decisamente poco adeguato nelle prime versioni. Ancora oggi alcuni ricordano i processori Prescott come dei veri "forni".

Prescott fu a ogni modo l'occasione per introdurre ulteriori novità alla piattaforma: a partire dalla serie 5xx Intel passò definitivamente al socket LGA (Land Grid Array). Prendendo tuttavia atto del fallimento dei piani originali, Intel fermò lo sviluppo di NetBurst (per cui erano già previste le varianti Tejas e Jayhawk), per iniziare a cambiare rotta e ritornare sulla strada dell'efficienza.

Cedar Mill

A partire dalla serie 6xx, Intel introdusse le varianti Cedar Mill, le quali non erano altro che dei processori Presler (con cui vennero realizzati i Pentium D), a cui era però stato disabilitato un core. I Pentium 4 di questa serie si avvantaggiarono di un processo produttivo più piccolo di 65nm, oltre alla nuova tecnologia costruttiva Strained Silicon: una tecnica costruttiva che, incrementando lo strato isolante del 15% tra gate ed elettrodi nei transistor, ridusse la dispersione di corrente, con un beneficio immediato sui consumi che scesero a 86W dai 130W di Prescott.

Oltre a ciò, i processori Cedar Mill implementavano anche la tecnologia Speed Step, che riduce la frequenza operativa in idle. Qualcosa che era già presente sui ben più efficienti Pentium M con architettura Banias.

Le CPU Cedar Mill sono inoltre i primi Pentium 4 a 64-bit, con cui era possibile superare il limite di reindirizzamento della RAM di 4GB attraverso le nuove istruzioni EM64T. Viene anche introdotta la tecnologia di virtualizzazione Vanderpool, per agevolare l'esecuzione di macchine virtuali.

Pentium 4 Extreme Edition

Anticipando poco più di una settimana AMD con i suoi Athlon 64 e Athlon 64 FX, il Pentium 4 Extreme Edition fu annunciato da Intel a settembre 2003. Questa versione più potente del Pentium 4 faceva uso del core Gallatine, utilizzato nelle CPU per server Xeon MP, ma adattato al socket 478 e dotato di un front side bus da 800MHz, che raddoppiava rispetto a Xeon.

Successivamente, venne adottato il core Prescott, che nell'ultimo modello commercializzato nel 2005 raggiunse la velocità di 3,73 GHz e fu abbinato a un FSB di 1066MHz.

La particolarità della gamma Extreme Edition, tuttavia, fu la cache aggiuntiva L3 da 2MB che, come accade sul più moderno Ryzen 7 5800X3D, aumentava le prestazioni sui giochi più esigenti che facevano uso di motori grafici id Tech 3 e Unreal Engine, ma le peggiorava leggermente nelle applicazioni lavorative.

A tutti gli effetti, questo concetto ha anticipato l'idea alla base della 3D V-Cache sui moderni Ryzen.

Smithfield, Presler e il Pentium Dual Core

Allo scopo di tenere il passo di AMD, che aveva già lanciato i primi processori dual core a 64-bit con l'Athlon 64 X2, Intel mise in commercio il Pentium D, realizzato nelle varianti Smithfield e Presler.

Smithfield

I primi Pentium D racchiudevano sostanzialmente due core Prescott, realizzati tramite il processo produttivo a 90nm, e inseriti all'interno dello stesso die. Trattandosi dell'ultima iterazione dell'architettura Prescott, oltre alle istruzioni più recenti, come le SSE3, era anche presente la tecnologia SpeedStep e l'Hyper Threading, anche se solo nelle versioni Extreme Edition.

Presler

Come accennato sopra, si trattava della variante dual core di Cedar Mill, che per questo motivo beneficiava del nuovo processo produttivo da 65nm e di frequenze operative leggermente più alte, che vanno dai 2,8GHz ai 3,4GHz. A differenza di Smithfield, le CPU Presler erano costruite attraverso un approccio a die doppio, utilizzando due core Presler separati.

Concorrenza: AMD Athlon 64, Athlon 64 X2 e Athlon 64 FX

Nonostante il successo commerciale non fu lo stesso di quello di Intel, gli Athlon 64 e la gamma di CPU di fascia alta Athlon 64 FX di AMD offriva prestazioni e consumi sostanzialmente migliori, grazie a un approccio totalmente opposto. I processori prodotti dalla casa di Sunnyvale riuscivano infatti a consumare molta meno corrente e, al tempo stesso, garantire prestazioni al livello dei Pentium 4 più veloci, ma a una frequenza più bassa.

Sia gli Athlon 64 che i modelli FX erano basati sull'architettura K8, poi rinominata K9 negli Athlon 64 X2, le prime CPU dual core AMD uscite sul mercato nel 2005 - anno in cui Intel lanciò i suoi Pentium D. Gli Athlon facevano anche già uso di un bus seriale, ovvero l'HyperTransport: un sistema bidirezionale e parallelo a bassa latenza, che consente di eliminare colli di bottiglia solitamente causati dai Front Side Bus classici, come il Quad Pumped dei Pentium 4, sebbene quest'ultimo sarà anche presente nei successivi e superiori Core 2 Duo e Core 2 Quad.

Per comunicare meglio questo vantaggio al livello commerciale, AMD decise di utilizzare il numero modello di ogni processore, come una sorta di "riferimento prestazionale": un Athlon 64 3600+, ad esempio, era pari a un Pentium 4 da 3.6GHz, nonostante la frequenza operativa inferiore di 2.4GHz.

Conclusioni

A partire dal 2006, Intel cambiò direzione con i Core 2 Duo e, successivamente dal 2007, con i Core 2 Quad, i primi processori quad-core. Con il nuovo design, denominato "Intel Core Microarchitecture", l'azienda torna a riprendersi la leadership sia per quanto riguarda le prestazioni pure sia per l'efficienza energetica: le nuove CPU infatti, oltre a superare definitivamente le controparti AMD, consumano molto meno.

Da quel periodo in poi AMD attraverserà un lungo periodo difficile, con prodotti non affatto all'altezza delle proposte Intel, riuscendo a risalire la china soltanto di recente coi Ryzen e l'architettura Zen, sebbene la situazione sia attualmente molto combattuta tra i due storici avversari.

Per Intel, comunque, resta il fatto che l'architettura NetBurst si rivelò inadeguata per l'utilizzo desktop, seppur pensata per un'elevata velocità d'esecuzione, parallelismo del codice e frequenze alte, principalmente per via della lunga pipeline veramente poco sfruttata per l'esigenze dell'epoca.

Nonostante il successo commerciale ottenuto, rappresenta a ogni modo una pietra miliare sia per Intel, da cui ha anche tratto una lezione, sia per l'informatica in generale, sia in positivo che in negativo.