Immagini IA sotto controllo, Google introduce nuove etichette per distinguerle

Google sta finalmente facendo qualcosa per le immagini AI, ma non è ancora abbastanza

Google ha annunciato che inizierà il lancio di una nuova funzione per aiutare gli utenti a "capire meglio come un particolare contenuto è stato creato e modificato".

Questo avviene dopo che l'azienda si è unita alla Coalition for Content Provenance and Authenticity (C2PA) - un gruppo di grandi marchi che cerca di combattere la diffusione di informazioni fuorvianti online, contribuendo anche a sviluppare l'ultima Content Credentials. Per chi non lo sapesse, anche Amazon, Adobe e Microsoft fanno parte del comitato.

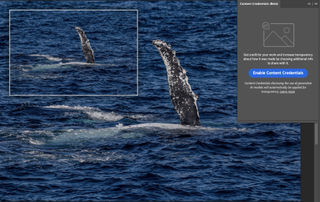

In attesa del rilascio nei prossimi mesi, Google afferma che utilizzerà le attuali linee guida per le credenziali del contenuto, ovvero i metadati di un'immagine, all'interno dei parametri di ricerca per aggiungere un'etichetta alle immagini generate o modificate dall'intelligenza artificiale, fornendo maggiore trasparenza agli utenti. Questi metadati includono informazioni come l'origine dell'immagine, oltre a quando, dove e come è stata creata.

Tuttavia, lo standard C2PA, che offre agli utenti la possibilità di risalire all'origine di diversi tipi di media, è stato rifiutato da molti sviluppatori di IA, come Black Forrest Labs, l'azienda dietro il modello Flux che X's (ex Twitter) Grok utilizza per la generazione di immagini.

Questo AI-flagging sarà implementato attraverso l'attuale finestra About This Image di Google, il che significa che sarà disponibile per gli utenti anche attraverso Google Lens e la funzione "Circle to Search" di Android. Quando sarà attiva, gli utenti potranno fare clic sui tre punti sopra un'immagine e selezionare "Informazioni su questa immagine" per verificare se è stata generata dall'intelligenza artificiale, quindi non sarà così evidente come speravamo.

È sufficiente?

Sebbene Google avesse bisogno di fare qualcosa riguardo alle immagini IA nei suoi risultati di ricerca, resta da chiedersi se un'etichetta nascosta sia sufficiente. Se la il tutto funziona come dichiarato, gli utenti dovranno eseguire ulteriori passaggi per verificare se un'immagine sia stata creata utilizzando l'intelligenza artificiale prima che Google la confermi. Chi non è già a conoscenza dell'esistenza della funzione About This Image potrebbe non rendersi conto di avere a disposizione un nuovo strumento.

Mentre i video deepfake stanno spopolando nel mondo della criminalità, le immagini generate dall'intelligenza artificiale sono quasi altrettanto problematiche. Donald Trump ha recentemente pubblicato immagini di Taylor Swift e dei suoi fan, renderizzate digitalmente, che sostenevano falsamente la sua campagna per la presidenza, e la stessa Swift è stata vittima di abusi sessuali basati su immagini quando i suoi nudi generati dall'IA sono diventati virali.

Ricevi approfondimenti quotidiani, ispirazione e offerte nella tua casella di posta

Iscriviti per ricevere ultime notizie, recensioni, opinioni, offerte tecnologiche e altro ancora.

Sebbene sia facile lamentarsi del fatto che Google non stia facendo abbastanza, anche Meta non è entusiasta di tirare fuori la polvere da sotto il tappeto. Il gigante dei social media ha recentemente aggiornato la sua politica per rendere meno visibili le etichette, spostando le informazioni rilevanti nel menu di un post.

Sebbene questo aggiornamento sia un primo passo positivo, saranno necessarie ulteriori misure aggressive per mantenere gli utenti informati e protetti. Altre aziende, come i produttori di fotocamere e gli sviluppatori di strumenti di intelligenza artificiale, dovranno accettare e utilizzare i watermark del C2PA per garantire la massima efficacia del sistema, poiché Google dipenderà da questi dati. Pochi modelli di fotocamera, come la Leica M-11P e la Nikon Z9, possiedono le funzioni Content Credentials integrate, mentre Adobe ha implementato una versione beta sia in Photoshop che in Lightroom. Ma ancora una volta, spetta all'utente utilizzare le funzioni e fornire informazioni accurate.

In uno studio dell'Università di Waterloo, solo il 61% delle persone è riuscito a distinguere le immagini generate dall'intelligenza artificiale da quelle reali. Se questi numeri sono accurati, il sistema di etichettatura di Google non offrirà alcuna trasparenza aggiuntiva a più di un terzo delle persone. Si tratta comunque di un passo positivo da parte di Google nella lotta per ridurre la disinformazione online, ma sarebbe bene che i giganti tecnologici rendessero queste etichette molto più accessibili.

Nato nel 1995 e cresciuto da due genitori nerd, non poteva che essere orientato fin dalla tenera età verso un mondo fatto di videogiochi e nuove tecnologie. Fin da piccolo ha sempre esplorato computer e gadget di ogni tipo, facendo crescere insieme a lui le sue passioni. Dopo aver completato gli studi, ha lavorato con diverse realtà editoriali, cercando sempre di trasmettere qualcosa in più oltre alla semplice informazione. Amante del cioccolato fondente, continua a esplorare nuove frontiere digitali, mantenendo sempre viva la sua curiosità e la sua dedizione al settore.