Google I/O 2024 - De 7 største AI-nyheder, fra Gemini til Android 15

Gemini, Gemini og mere Gemini

Støvet har nu lagt sig over Google I/O 2024-keynoten, og der er ingen tvivl om, hvad det store tema var - Google Gemini og nye AI-værktøjer dominerede fuldstændigt annonceringerne og gav os et glimt af, hvor vores digitale liv er på vej hen. CEO Sundar Pichai gjorde ret i at beskrive begivenheden som sin version af The Eras Tour - specifikt "Gemini-æraen" - helt i toppen.

I modsætning til tidligere år handlede hele keynoten om Gemini og AI; faktisk sagde Google sidstnævnte i alt 121 gange. Fra afsløringen af en futuristisk AI-assistent kaldet "Project Astra", der kan køre på en telefon - og måske en dag på smarte briller - til Gemini, der indgår i næsten alle tjenester eller produkter, som virksomheden tilbyder, var kunstig intelligens helt klart det dominerende tema.

Den to timer lange keynote var rigeligt lang for alle andre end de mest ivrige AI-entusiaster, så vi har samlet de 7 vigtigste ting, som Google annoncerede under sin I/O 2024-keynote - og inkluderet de seneste nyheder om, hvornår vi rent faktisk kan se de nye funktioner.

1. Google lancerede Project Astra - en "AI-agent" til hverdagen

Det viser sig, at Google har et svar på OpenAI's GPT-4o og Microsofts CoPilot. Project Astra, som kaldes en "AI-agent" til hverdagen, er i bund og grund Google Lens på steroider og ser virkelig imponerende ud, idet den er i stand til at forstå, ræsonnere og reagere på live video og lyd.

Det blev demonstreret på en Pixel-telefon i en optaget video, hvor man så brugeren gå rundt på et kontor, give et live-feed fra bagkameraet og stille Astra spørgsmål ud af det blå. Gemini så og forstod det visuelle, samtidig med at hun besvarede spørgsmålene.

Det taler for den multimodale og lange kontekst i Geminis backend, som arbejder på hurtigt at identificer indholdet og levere et svar. I demonstrationen vidste den, hvad en bestemt del af en højttaler var, og kunne endda identificere et område i London. Den er også generativ, fordi den hurtigt skabte et bandnavn til en sød hvalp ved siden af et tøjdyr (se videoen ovenfor).

Denne funktion vil ikke blive rullet ud med det samme, men udviklere og pressefolk som vores TechRadar-kolleger vil få mulighed for at prøve den på I/O 2024. Og selv om Google ikke præciserede det, var der en teaser med briller til Astra, hvilket kan betyde, at Google Glass kan få et comeback.

Get the best Black Friday deals direct to your inbox, plus news, reviews, and more.

Sign up to be the first to know about unmissable Black Friday deals on top tech, plus get all your favorite TechRadar content.

Men selv som demo under Google I/O er det virkelig imponerende og potentielt meget overbevisende. Den kan overgå smartphones og de nuværende assistenter, vi har fra Google og endda Apple. Desuden viser den også Googles sande AI-ambitioner, et værktøj, der kan være enormt nyttigt og slet ikke besværligt at bruge.

- Hvornår bliver den lanceret?? Ukendt lige nu - Google beskriver det som "vores vision for fremtidens AI-assistenter".

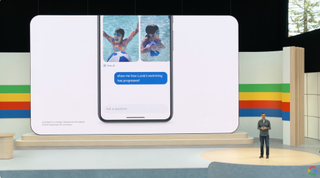

2. Google Fotos fik et nyttigt AI-boost fra Gemini

Har du nogensinde ønsket hurtigt at finde et bestemt foto, du har taget på et tidspunkt i en fjern fortid? Måske er det en besked fra en, du holder af, et tidligt billede af en hund som hvalp eller endda din nummerplade. Nu gør Google det ønske til virkelighed med en stor opdatering af Google Photos der forbinder den med en Gemini. Det giver den adgang til dit bibliotek, lader den søge i det og leverer nemt det resultat, du leder efter.

I en demonstration på scenen afslørede Sundar Pichai, at du kan bede den om din nummerplade, og Photos vil levere et billede, der viser den og de cifre/tegn, der udgør din nummerplade. På samme måde kan du bede om billeder af, hvornår dit barn lærte at svømme sammen med flere detaljer. Det skulle gøre selv de mest uorganiserede fotobiblioteker lidt lettere at søge i.

Google har døbt denne funktion "Ask Photos" og vil rulle den ud til alle brugere i de "kommende uger". Og den vil næsten helt sikkert være praktisk og gøre folk, der ikke bruger Google Fotos, en smule misundelige.

- Hvornår bliver den lanceret? "Ii de kommende måneder" som en eksperimentel funktion, ifølge Google

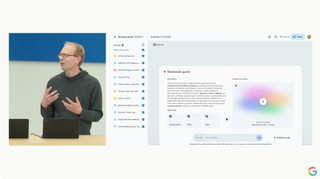

3. Dit barns lektier er lige blevet meget lettere takket være NotebookLM

Alle forældre kender til rædslen ved at forsøge at hjælpe børn med lektier; hvis du nogensinde har vist, hvordan man løser ligninger eller bøjer verber, er det ikke altid, at du lige kan finde den viden frem 20 år efter, at du selv blev hørt i tingenen. Men Google har måske lige gjort opgaven meget lettere takket være en opgradering af note-appen NotebookLM.

NotebookLM har nu adgang til Gemini 1.5 Pro, og baseret på den demo, der blev givet på I/O 2024, vil den nu være en bedre lærer, end du nogensinde har været. Demoen viste Googles Josh Woodward, der læste en notesbog fyldt med noter om et læringsemne - i dette tilfælde videnskab. Med et enkelt tryk på en knap kunne han oprette en detaljeret læringsguide med yderligere output, herunder quizzer og ofte stillede spørgsmål, alt sammen hentet fra kildematerialet.

Imponerende - men det blev meget bedre. En ny funktion - som stadig er en prototype - kunne udsende alt indholdet som lyd, hvilket i bund og grund skabte en diskussion i podcast-stil. Desuden indeholdt lyden mere end én taler, som snakkede naturligt om emnet på en måde, der helt sikkert ville være mere hjælpsom end en frustreret forælder, der forsøgte at spille rollen som lærer.

Woodward var endda i stand til at afbryde og stille et spørgsmål, i dette tilfælde "giv os et basketball-eksempel" - hvorefter AI'en skiftede spor og kom med kloge metaforer for emnet, men i en tilgængelig kontekst. Forældrene på TechRadar-teamet glæder sig til at prøve den her.

- Hvornår bliver den lanceret? Uvist lige nu

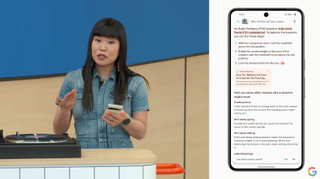

4. Snart kan du søge på Google med en video

I en mærkelig demonstration på scenen med en pladespiller viste Google et meget imponerende nyt søgetrick. Man kan nu optage en video og søge i den for at få resultater og forhåbentlig et svar.

I dette tilfælde var det en Googler, der undrede sig over, hvordan man bruger en pladespiller; hun trykkede på optageren for at filme den pågældende enhed, mens hun spurgte om noget, og sendte den derefter af sted. Google udførte sin søgemagi og gav et svar i tekst, som kunne læses højt. Det er en helt ny måde at søge på, ligesom Google Lens til video, og det adskiller sig også markant fra det kommende Project Astra everyday AI, da det skal optages og derefter søges i stedet for at arbejde i realtid.

Alligevel er det en del af en Gemini- og generativ AI-infusion med Google Search, der sigter mod at holde dig på den side og gøre det lettere at få svar. Før denne demo af søgning med video viste Google en ny generativ oplevelse for opskrifter og spisesteder. Det giver dig mulighed for at søge efter noget på et naturligt sprog og få opskrifter eller endda anbefalinger af spisesteder på resultatsiden.

Google giver ganske enkelt den fuld gas med generativ AI i søgninger, både for resultater og forskellige måder at få resultaterne på.

- Hvornår bliver den lanceret?? Google siger, at "søgning med video snart vil være tilgængelig for Search Labs-brugere på engelsk i USA" og vil "udvide til flere regioner over tid".

5. Google tager kampen op med OpenAI's Sora med sit Veo-videoværktøj

We har beundret kreationerne fra OpenAI's tekst-til-video værktøj Sora i de sidste par måneder, og nu slutter Google sig til den generative videofest med sit nye værktøj kaldet Veo. Ligesom Sora kan Veo generere minutlange videoer i 1080p-kvalitet, alt sammen ud fra en simpel besked.

Den opfordring kan omfatte filmiske effekter, som en anmodning om en time-lapse eller et luftfoto, og de første eksempler ser imponerende ud. Du behøver heller ikke at starte fra bunden - upload en inputvideo med en kommando, og Veo kan redigere klippet, så det passer til dine ønsker. Der er også mulighed for at tilføje masker og justere specifikke dele af en video.

Den dårlige nyhed? Ligesom Sora er Veo ikke bredt tilgængelig endnu. Google siger, at det vil være tilgængeligt for udvalgte skabere gennem VideoFX, en af de eksperimentelle Labs-funktioner, "i løbet af de kommende uger". Der kan gå et stykke tid, før vi ser en bred udrulning, men Google har lovet at bringe funktionen til YouTube Shorts og andre apps. Og det vil få Adobe til at skifte uroligt i sin AI-genererede stol.

- Hvornår bliver den lanceret?? Du kan nu skrive dig på Veos venteliste. Google oplyser, at det vil være "tilgængeligt for udvalgte skabere i privat forhåndsvisning i VideoFX". Google siger også, at "i fremtiden vil vi også bringe nogle af Veos muligheder til YouTube Shorts" og andre produkter

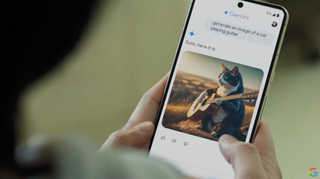

6. Android får en stor Gemini-opgradering

Ligesom Googles "Circle to Search"-funktion ligger oven på en applikation, bliver Gemini nu integreret i kernen af Android for at integrere med dit flow. Som demonstreret kan Gemini nu se, læse og forstå, hvad der er på din telefons skærm, så den kan forudse spørgsmål om det, du ser.

Så den kan få konteksten for en video, du ser, forudse en anmodning om opsummering, når du ser en lang PDF, eller være klar til utallige spørgsmål om en app, du er inde i. At have en indholdsbevidst AI indbygget i en telefons operativsystem er på ingen måde en dårlig ting og kan vise sig at være super nyttigt.

Ud over at Gemini bliver integreret på systemniveau, vil Gemini Nano med multimodalitet blive lanceret senere på året på Pixel-enheder. Hvad vil det muliggøre? Det burde gøre tingene hurtigere, men den vigtigste funktion lige nu er, at Gemini lytter til opkald og kan advare dig i realtid, hvis det er spam. Det er ret sejt og bygger på opkaldsscreening, som længe har været en del af Pixel-telefonerne. Den er klar til at være hurtigere og behandle mere på enheden i stedet for at sende det til skyen.

- Hvornår bliver den lanceret? Google siger, at 'Gemini Nano med multimodalitet' vil være tilgængelig "på Pixel senere i år". Forbedringer af Circle to Search og den nye funktion til banksvindel ved telefonopkald kommer også "senere i år".

7. Google Workspace bliver meget klogere

Workspace-brugere får en guldgrube af Gemini-integrationer og nyttige funktioner, som kan få stor betydning i hverdagen. I Mail kan du, takket være et nyt sidepanel til venstre, bede Gemini om at opsummere alle de seneste samtaler med en kollega. Resultatet opsummeres derefter med punktopstillinger, der fremhæver de vigtigste aspekter.

Gemini i Google Meet kan give dig højdepunkterne i et møde, eller hvad andre folk i samtalen måske spørger om. Du behøver ikke længere at tage noter under opkaldet, hvilket kan vise sig at være nyttigt, hvis det er langvarigt. I Google Sheets kan Gemini hjælpe med at skabe mening i data og behandle anmodninger som f.eks. at trække en bestemt sum eller et bestemt datasæt.

Den virtuelle holdkammerat "Chip" er måske det mest futuristiske eksempel. Den kan leve i en G-chat og blive kaldt op til forskellige opgaver eller forespørgsler. Mens disse værktøjer vil finde vej til Workspace, sandsynligvis først gennem Labs, er det resterende spørgsmål, hvornår de kommer til almindelige Gmail- og Drive-kunder. I betragtning af Googles tilgang til AI for alle og det store fokus på søgning, er det sandsynligvis et spørgsmål om tid.

- Hvornår bliver den lanceret? Geminis sidepanel i Gmail, Docs, Drive, Slides og Sheets vil blive opgraderet til Gemini 1.5 Pro "fra i dag" (14. maj). I Gmail-appen vil funktionen "opsummering af e-mails" være tilgængelig for Workspace Labs-brugere "i denne måned" (maj) og for Gemini for Workspace-kunder og Google One AI Premium-abonnenter "i næste måned".

Læs også...

Peter er journalist og har arbejdet som tech-journalist på forskellige tech-medier. Samlet set har han beskæftiget sig professionelt med tech og forbrugerelektronik siden 1996. Peter interesserer sig for mange forskellige områder inden for forbrugerelektronik. Han er vild med lyd – både høretelefoner og højttalere i alle mulige afskygninger. Men han kan også bruge rigtig langt tid på at teste mobiltelefoner og computere. Samtidig er han altid på udkig efter sære og skæve produkter, der kan være interessante at kigge nærmere på, selv om de måske ikke passer ind i de traditionelle produktgrupper.

- Mark WilsonSenior news editor

- Marc McLarenGlobal Editor in Chief