Nvidia e Google condividono 16 GPU Ampere A100 su Google Cloud

Tramite Google Cloud sviluppatori e scienziati potranno accedere alla potenza degli acceleratori Nvidia

Nvidia e Google hanno avviato una partnership per rendere disponibili delle istanze ottimizzate per l’acceleratore VM (A2) basate sulle GPU Ampere A100.

La nuova famiglia di istanze A2 VM è destinata alle operazioni che richiedono grandi capacità di calcolo, come l’intelligenza artificiale, l’analisi dei dati e l‘informatica scientifica.

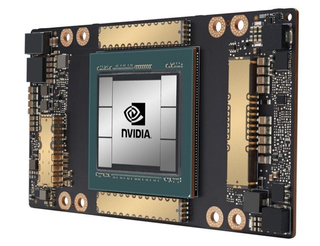

Introdotte a metà maggio, le GPU Nvidia A100 Tensor Core dispongono di 6912 CUDA core e sono equipaggiate con 40GB di memoria HBM2, in grado di raggiungere una larghezza di banda di 1.6 TB/s. Gli acceleratori offrono prestazioni di calcolo incredibili pari a 9.7 TFLOPS con gamma di precisione FP32, che salgono a 19.5 TFLOPS con gamma di precisione FP64 e a 624 TOPs (Tera operazioni al secondo) con standard INT8.

- Le migliori schede video del 2020

- Le migliori schede madri del 2020

- Le migliori schede grafiche Nvidia del 2020

Nvidia A100

Google e Nvidia prevedono che le nuove GPU A100 Tensor Core aumentino di circa 20 volte le prestazioni in termini di apprendimento e inferenza rispetto ai processori appartenenti alla precedente generazione.

Le istanze ottimizzate per VM (A2) sono disponibili su richiesta in versione alpha e verranno condivise con differenti livelli prestazionali in base alle necessità del richiedente. Coloro che hanno a che fare con carichi di lavoro fino a 312 TFLOPS di prestazioni FP64 o fino a 20 POPS di prestazioni con gamma di precisione INT4, accederanno all’istanza A2-megagpu-16G, alimentata da 16 GPU NVIDIA A100 interconnesse tramite un NVSwitch con 640 GB di memoria HBM2, 96 vCPUs, e 1.3 TB di memoria di sistema. Coloro che necessitano di minore potenza possono invece sfruttare l’istanza A2-highgpu-1G, alimentata da un singolo acceleratore A100 e da un processore Intel Cascade Lake da 12 core.

L’apertura al pubblico è prevista per la fine dell’anno. Google afferma che gli acceleratori NVIDIA A100 saranno supportati dal GKE (Google Kubernetes Engine), dalla piattaforma Cloud AI e da altri servizi Google Cloud.

Google Cloud è il primo servizio a fornire il supporto alla tecnologia Nvidia A100. L’azienda sta inoltre utilizzando server NVIDIA HGX A100 concepiti e costruiti sotto la supervisione del produttore di GPU.

Sei un professionista? Iscriviti alla nostra Newsletter

Iscriviti alla newsletter di Techradar Pro per ricevere tutte le ultime notizie, opinioni, editoriali e guide per il successo della tua impresa!

Anton Shilov is the News Editor at AnandTech, Inc. For more than four years, he has been writing for magazines and websites such as AnandTech, TechRadar, Tom's Guide, Kit Guru, EE Times, Tech & Learning, EE Times Asia, Design & Reuse.