Nvidia sta per lanciare l’hardware AI più potente al mondo

Il Superchip CPU Grace è il primo chip Arm di Nvidia solo per CPU

Al GTC 2022, Nvidia ha presentato il suo nuovo Superchip CPU Grace progettato per l’infrastruttura AI e il computing ad alte prestazioni.

Per essere precisi, la nuova CPU per data center discreta basata su Arm Neoverse a 144 core è in realtà composta da due chip CPU collegati tramite interconnessione chip-to-chip (C2C) di NVLink, azienda divenuta celebre per il connubio tra alta velocita e bassa latenza dei suoi prodotti.

Il Grace CPU Superchip di Nvidia integra anche il Superchip Grace Hopper (che era stato annunciato lo scorso anno) e presenta una CPU e GPU integrate su una scheda carrier. Sebbene di diversa composizione, entrambi i Superchip condividono la stessa architettura CPU e l’interconnessione NVLink-CNC.

Nell'ambito di un comunicato stampa, il fondatore e CEO di Nvidia, Jensen Huang, ha dichiarato che il Grace CPU Superchip è l’ideale per i carichi di lavoro AI, specificando:

“È emerso un nuovo tipo di data center: le industrie AI che elaborano e perfezionano montagne di dati per produrre ulteriori intelligenze. Il Grace CPU Superchip offre le massime prestazioni, larghezza di banda di memoria e piattaforme software NVIDIA in un unico chip. Sarà la CPU dell’infrastruttura AI più potente al mondo”.

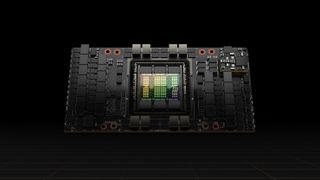

Nvidia H100 DGX H100

Nel tentativo di alimentare la prossima ondata di data center AI, Nvidia ha anche annunciato la sua piattaforma di elaborazione accelerata di nuova generazione con architettura Nvidia Hopper, che prende il posto della precedente Nvidia Ampere (lanciata due anni fa).

Il produttore di chip ha persino annunciato la sua prima GPU con architettura Hopper dotata di ben 80 miliardi di transistor. Al momento, Nvidia H100 è l’acceleratore più grande e potente al mondo e, come il Grace CPU Superchip, include anche l’interconnessione NVLink per (giganteschi) modelli linguistici avanzati di AI, sistemi di raccomandazione profondi, genomica e gemelli digitali complessi.

Sei un professionista? Iscriviti alla nostra Newsletter

Iscriviti alla newsletter di Techradar Pro per ricevere tutte le ultime notizie, opinioni, editoriali e guide per il successo della tua impresa!

Per le aziende che desiderano ancora più potenza, il DGX H100 di Nvidia (il suo sistema DGX di quarta generazione) è dotato di otto GPU H100 e, grazie alla nuova precisione di FP8, può fornire 32 petaflop di prestazioni AI. Ciò fornisce la scala adeguata a soddisfare gli esigenti requisiti di calcolo di modelli linguistici di grandi dimensioni, sistemi di raccomandazione, ricerca sanitaria e scienze del clima.

Vale la pena notare che tutte le GPU nei sistemi DGX H100 di Nvidia sono collegate tramite NVLink per garantire una connettività a 900 GB/s.

La nuova architettura Hopper dell’azienda ha già ricevuto un ampio supporto dal settore dei principali fornitori di cloud computing. Inoltre, Alibaba Cloud, AWS, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud e Tencent Cloud hanno tutti in programma di offrire istanze basate su H100.

Allo stesso tempo, Cisco, Dell Technologies, HPE, Inspur, Lenovo e altri produttori di sistemi hanno in programma di rilasciare server con acceleratori H100.

La GPU H100 di Nvidia dovrebbe essere disponibile in tutto il mondo entra la fine dell’anno da fornitori di servizi cloud, produttori di computer e, infine, direttamente dall’azienda stessa.

- I migliori droni del 2022