Los AirPods con cámaras para Visual Intelligence podrían ser una de las mejores funciones de seguridad personal que Apple ha planeado

Por qué sería bueno que Apple pusiera ojos en tus oídos

- Se dice que Apple sigue trabajando en las cámaras de los AirPods

- La Inteligencia Visual de iOS 18 está en el centro de los planes de Apple

- Las funciones aún están "a varias generaciones de distancia"

¿Alguna vez has escuchado hablar de "que" - Apple está experimentando con cámaras en sus AirPods -? Al parecer por fin conocemos el "por qué" detrás de este movimoento.

Un nuevo informe arroja luz sobre los planes de Apple para los futuros AirPods, y si la tecnología puede hacer lo que promete, podría ser una característica de seguridad personal realmente importante.

Sin embargo, hay una advertencia importante: las características están "todavía al menos a varias generaciones de distancia de llegar al mercado".

El informe procede del bien relacionado Mark Gurman de Bloomberg, que afirma que "el plan definitivo de Apple para la Inteligencia Visual va mucho más allá del iPhone". Y los AirPods son una parte importante de ese plan.

Según Gurman, la Visual Intelligence - reconocer el mundo que te rodea y proporcionar información útil o asistencia - se considera un asunto muy importante dentro de Apple, y está planeando poner cámaras tanto en el Apple Watch como en el Apple Watch Ultra también. Al igual que con los AirPods, "esto ayudaría al dispositivo a ver el mundo exterior y utilizar la IA para ofrecer información relevante".

¿Cómo funcionarían los AirPods con Visual Intelligence?

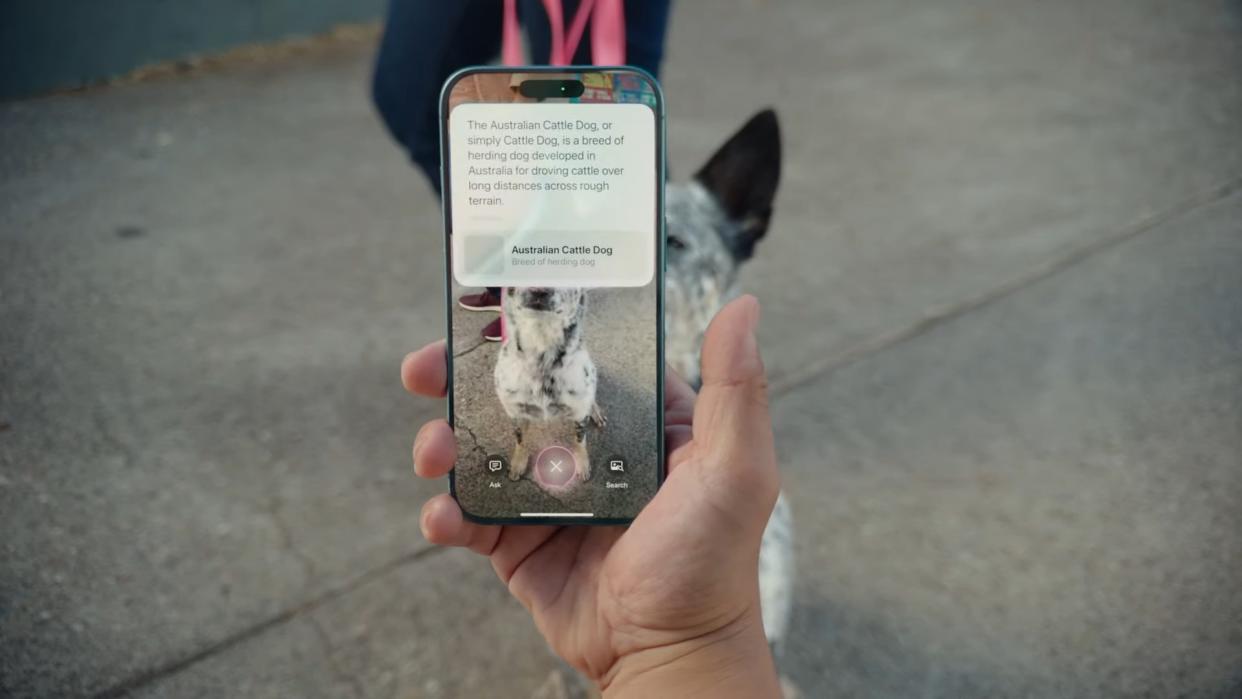

Visual Intelligence se introdujo en iOS 18 para el iPhone 16, y permite apuntar con la cámara a algo y saber más sobre ello: el tipo de planta, la raza del perro (como en la imagen que encabeza este artículo), el horario de apertura de la cafetería que acabas de encontrar, etc.

Visual Intelligence también puede traducir texto, y quizá algún día pueda ayudar a personas como yo, que tenemos una memoria asombrosamente mala para los nombres y las caras.

Obtenga información, inspiración y ofertas diarias en su bandeja de entrada

Regístrese para recibir noticias de última hora, reseñas, opiniones, ofertas de alta tecnología y más.

El gran problema de la Inteligencia Visual, sin embargo, es que tienes que sacar el teléfono para hacerlo. Y hay circunstancias en las que no querrás hacerlo. Me recuerda a cuando Apple llevó Mapas al Apple Watch: al hacer posible usar Mapas sin transmitir «No soy de aquí y estoy irremediablemente perdido. Además tengo un teléfono muy caro» a todos los villanos del barrio, fue una importante función de seguridad personal.

Esto también podría serlo. Si Apple hace posible invocar la Inteligencia Visual con un punto de la cabeza y un apretón de los tallos, eso permitiría obtener información importante -como la traducción de una señal de dirección en otro país- sin agitar el teléfono.

Estamos muy lejos de disponer realmente de estas funciones: no las esperes en los AirPods Pro 3, que probablemente llegarán más adelante en 2025. Pero me entusiasma la idea: imagina la Inteligencia de Apple, pero bien.

También puedes leer...