Il nuovo chip AI di Cerebras supera Nvidia DGX100: velocità e potenza senza precedenti

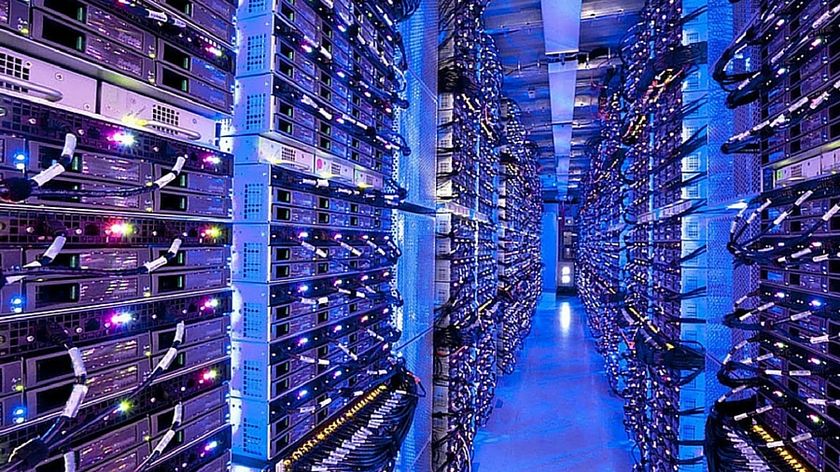

Cerebras offre un'intelligenza artificiale "istantanea"

Cerebras ha presentato il suo ultimo chip per l'inferenza dell'intelligenza artificiale, presentato come un temibile rivale del DGX100 di Nvidia.

Il chip dispone di 44 GB di memoria ad alta velocità, che gli consentono di gestire modelli di intelligenza artificiale con miliardi o trilioni di parametri.

Per i modelli che superano la capacità di memoria di un singolo wafer, Cerebras è in grado di suddividerli ai confini dello strato, distribuendoli su più sistemi CS-3. Un singolo sistema CS-3 può ospitare 20 miliardi di modelli di parametri, mentre 70 miliardi di modelli di parametri possono essere gestiti da soli quattro sistemi.

Supporto di altri modelli in arrivo

Cerebras enfatizza l'uso dei pesi del modello a 16 bit per mantenere l'accuratezza, a differenza di alcuni concorrenti che riducono la precisione dei pesi a 8 bit, il che può degradare le prestazioni. Secondo Cerebras, i suoi modelli a 16 bit hanno prestazioni fino al 5% superiori nelle conversazioni a più turni, nei compiti matematici e di ragionamento rispetto ai modelli a 8 bit, garantendo risultati più accurati e affidabili.

La piattaforma di inferenza Cerebras è disponibile tramite accesso alla chat e alle API ed è stata progettata per essere facilmente integrata dagli sviluppatori che hanno familiarità con il formato Chat Completions di OpenAI. La piattaforma vanta la capacità di eseguire modelli Llama3.1 70B a 450 token al secondo, il che la rende l'unica soluzione in grado di raggiungere una velocità istantanea per modelli così grandi. Per gli sviluppatori, Cerebras offre 1 milione di token gratuiti al giorno al momento del lancio, mentre i prezzi per le implementazioni su larga scala saranno significativamente inferiori a quelli dei più diffusi cloud di GPU.

Cerebras sta lanciando inizialmente i modelli Llama3.1 8B e 70B, con l'intenzione di aggiungere il supporto per modelli più grandi come Llama3 405B e Mistral Large 2 nel prossimo futuro. L'azienda sottolinea che le capacità di inferenza rapida sono fondamentali per consentire flussi di lavoro AI più complessi e migliorare l'intelligenza LLM in tempo reale, in particolare in tecniche come lo scaffolding, che richiede un uso sostanziale di token.

Patrick Kennedy di ServeTheHome ha visto il prodotto in azione al recente simposio Hot Chips 2024 e ha dichiarato: "Ho avuto l'opportunità di sedermi con Andrew Feldman (CEO di Cerebras) prima dell'intervento e mi ha mostrato le demo dal vivo. È oscenamente veloce. Il motivo per cui questo è importante non è solo per l'interazione tra umani. In un mondo di agenti, invece, gli agenti di IA computerizzati parlano con diversi altri agenti di IA computerizzati. Immaginate che ogni agente impieghi pochi secondi per produrre un output e che ci siano più passaggi in questa pipeline. Se si pensa a pipeline automatizzate di agenti AI, allora è necessario un inferencing veloce per ridurre i tempi dell'intera catena".

Sei un professionista? Iscriviti alla nostra Newsletter

Iscriviti alla newsletter di Techradar Pro per ricevere tutte le ultime notizie, opinioni, editoriali e guide per il successo della tua impresa!

Cerebras posiziona la sua piattaforma come un nuovo standard nello sviluppo e nella distribuzione di LLM aperti, offrendo prestazioni da record, prezzi competitivi e un ampio accesso alle API. È possibile provarla collegandosi a inference.cerebras.ai o scansionando il codice QR nella diapositiva sottostante.

Nato nel 1995 e cresciuto da due genitori nerd, non poteva che essere orientato fin dalla tenera età verso un mondo fatto di videogiochi e nuove tecnologie. Fin da piccolo ha sempre esplorato computer e gadget di ogni tipo, facendo crescere insieme a lui le sue passioni. Dopo aver completato gli studi, ha lavorato con diverse realtà editoriali, cercando sempre di trasmettere qualcosa in più oltre alla semplice informazione. Amante del cioccolato fondente, continua a esplorare nuove frontiere digitali, mantenendo sempre viva la sua curiosità e la sua dedizione al settore.