Nvidia presenta el hardware de Inteligencia Artificial más potente del mundo

El Grace CPU Superchip es el primer chip Arm de Nvidia solo para CPU

Nvidia ha presentado en el GTC 2022 su nueva CPU Grace Superchip, diseñada para la infraestructura de IA y la informática de alto rendimiento.

La nueva CPU para centros de datos basada en Arm Neoverse de 144 núcleos se compone en realidad de dos chips de CPU conectados a través de la interconexión chip a chip (C2C) de alta velocidad y baja latencia de la compañía, NVLink.

El superchip de CPU Grace de Nvidia complementa su superchip Grace Hopper, anunciado el año pasado, que incluye una CPU y una GPU en una placa base. Aunque su composición puede ser diferente, ambos superchips comparten la misma arquitectura de CPU subyacente, así como la interconexión NVLink-CNC.

El fundador y consejero delegado de Nvidia, Jensen Huang, explicó en un comunicado de prensa cómo el superchip de CPU Grace es ideal para las cargas de trabajo de IA, diciendo:

"Ha surgido un nuevo tipo de centro de datos: fábricas de IA que procesan y refinan montañas de datos para producir inteligencia. El Superchip CPU Grace ofrece el mayor rendimiento, ancho de banda de memoria y plataformas de software NVIDIA en un solo chip y brillará como la CPU de la infraestructura de IA del mundo".

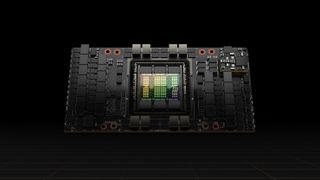

Nvidia H100 y DGX H100

En un esfuerzo por alimentar la próxima ola de centros de datos de IA, Nvidia también ha anunciado su plataforma de computación acelerada de próxima generación con la arquitectura Nvidia Hoppper, que sucede a la arquitectura Nvidia Ampere de la compañía, lanzada hace dos años.

El fabricante de chips incluso ha anunciado su primera GPU basada en Hopper, que cuenta con 80.000 millones de transistores. El Nvidia H100 es el acelerador más grande y potente del mundo hasta la fecha y, al igual que el Superchip de CPU Grace, también cuenta con la interconexión NVLink para el avance de gigantescos modelos de lenguaje de IA, sistemas de recomendación profunda, genómica y complejos gemelos digitales.

Obtenga información, inspiración y ofertas diarias en su bandeja de entrada

Regístrese para recibir noticias de última hora, reseñas, opiniones, ofertas de alta tecnología y más.

Para las empresas que quieren aún más potencia, el DGX H100 de Nvidia (su sistema DGX de cuarta generación) cuenta con ocho GPU H100 y puede ofrecer 32 petaflops de rendimiento de IA con la nueva precisión FP8. Esto proporciona la escala necesaria para satisfacer los requisitos de cálculo masivo de los grandes modelos de lenguaje, los sistemas de recomendación, la investigación sanitaria y la ciencia del clima. Cabe destacar que todas las GPU de los sistemas DGX H100 de Nvidia están conectados mediante NVLink para proporcionar una conectividad de 900GB/s.

La nueva arquitectura Hopper de la compañía ya ha recibido un amplio apoyo por parte de los principales proveedores de computación en la nube y Alibaba Cloud, AWS, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud y Tencent Cloud tienen previsto ofrecer instancias basadas en H100. Al mismo tiempo, Cisco, Dell Technologies, HPE, Inspur, Lenovo y otros fabricantes de sistemas tienen previsto lanzar servidores con aceleradores H100.

Se espera que la GPU H100 de Nvidia esté disponible en todo el mundo a finales de este año a través de proveedores de servicios en la nube, fabricantes de ordenadores y directamente de la propia compañía.

- We've also highlighted the best small business servers and the best workstations

Editor en TechRadar España de día, guitarrista de blues y friki de los cómics de noche. ¿O era al revés?

Más Populares