Här är hemligheten bakom AI-uppskalningsteknologi för 8K

Uppskalningens historia och varför AI är en verklig game-changer

Samsungs affärsstrategi 2020 för TV-försäljning är enkel: 8K eller stick. Då deras QLED 4K-TV-försäljning undermineras av budget 4K-TV planerar Samsung att flytta på marknaden igen, till ett format som (hittills) har mycket få konkurrenter, men också väldigt lite färdigt innehåll.

Men som vi såg i vårt jämförelsetest mellan 4K och 8K tidigare i år, behöver du faktiskt inte videofilma i upplösning om 7680 × 4320 (8K) för att dra full nytta av de miljoner pixlarna - Samsungs 8K TV använder AI-uppskalning för att konvertera alla videotyper (från SD till 4K och allt däremellan) till 8K-upplösning.

Uppskalning är naturligtvis inte något nytt. I flera år hittade 4K- och till och med HD-apparater sätt att anpassa innehåll med lägre upplösning för att passa det större pixel-per-tum-förhållandet för moderna TV-apparater. Men med 8K-tv-apparater som behöver fylla fyra 4K-tv-värden av pixlar fungerar vanliga uppskalningsmetoder helt enkelt inte, av skäl som vi kommer in på nedan.

Efter att ha besökt Samsung QA Labs i New Jersey och pratat med deras ingenjörer har vi en bättre uppfattning om hur Samsung använder konstgjord intelligens och maskininlärning för att möjliggöra 8K-uppskalning - och hur dess AI-tekniker står sig mot andra TV-tillverkares tidiga AI ansträngningar.

Varför konventionell uppskalning såg så hemsk ut

Före 1998 sändes tv i upplösning om 720x480 och filmer som filmats i högre kvalitet komprimerades för att passa detta format. Det är 345 600 pixlar med innehåll, som idag bara skulle ta upp ett litet utrymme på moderna TV-apparater med högre pixel-per-tum (PPI)-förhållanden. Och SD-innehållet? Det måste sträckas för att passa över 2 miljoner pixlar för högupplöst, över 8 miljoner för 4K eller över 33 miljoner för 8K.

Baslinjen för uppskalning är att upprätthålla rätt pixelförhållande genom enkel multiplikation. För att konvertera HD till 4K måste TV:nss processor förstora en HD-pixel för att ta upp fyra pixlars utrymme på skärmen med högre upplösning. Eller 16 pixlar under en HD-till-8K-konvertering.

Utan någon bildbehandling blir bilden, för att citera Tolkien, "liksom uttänjd, som smör skrapat över för mycket bröd." Varje databit blir onaturligt kvadratisk, utan en naturlig övergång mellan detaljer och färger. Resultatet är mycket "lego" eller brus runt objekt på skärmen.

Get the best Black Friday deals direct to your inbox, plus news, reviews, and more.

Sign up to be the first to know about unmissable Black Friday deals on top tech, plus get all your favorite TechRadar content.

Du kommer antagligen också se något som kallas "myggbrus". För att komprimera en video för att arbeta för din begränsade internetbandbredd måste tv-sändare och webbplatser fylla strömmen med avsiktliga färgfel, eller "komprimeringsartifakter". De medvetet felaktiga pixlarna kommer att svärma runt delar av skärmen där det finns skarpa kontraster, som den bruna bron framför blå himmel i bilden ovan.

Matematiken bakom uppskalning

Mot bakgrund av dessa problem lärde TV-programmerare sina TV-apparater att analysera och bearbeta bilderna i realtid för att fylla i eller reparera saknade eller skadade pixlar. Och de åstadkom detta med matematiska funktioner, vilket du kan berätta för dina nära och kära nästa gång de säger att för mycket TV får din hjärna att ruttna.

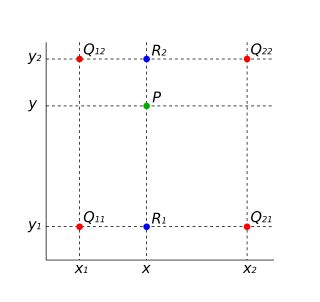

Specifikt lärde ingenjörer TV-processorn att interpolera vad varje saknad pixels färgvärde ska vara, baserat på dess omgivande pixlar. För att göra det, var man tvungen att definiera dess kärna: funktionen som tilldelar färgprioritet till en pixels grannar, baserat på deras närhet.

Den mest grundläggande kärnan som används i TV-apparater är närmaste grannkärnor, som helt enkelt beräknar vilken pixel som är närmast en ledig pixel och klistrar in samma färgdata i den tomma pixeln. Denna metod får bilden att ta ett blockigt sicksackmönster, eller aliasing, med dåliga kanter. Tänkt dig en svart bokstav "A" på en vit skärm; en saknad pixel precis utanför bokstaven kan fyllas i som svart, medan en pixel på kanten av bokstaven kan visas som vit. Resultatet blir antingen en grå klump runt bokstaven eller en snygg trappa med svartvitt som går upp och ner.

Bilinear interpolation kräver mer processorkraft men är mer effektiv. I denna metod jämförs den tomma pixeln mot de närmaste två grannarna för att bilda en linjär gradient mellan dem, vilket skärper bilden. Detta ger jämnare bild, men kan vara inkonsekvent. Så andra TV-apparater använder bikubisk interpolering, som drar information från de 16 närmaste pixlarna i alla riktningar. Medan denna metod troligtvis får färgen så nära exakt som möjligt, ger den också vanligtvis en mycket mer oskarp bild, med kanter som får en distraherande haloeffekt.

Du kan antagligen gissa problemet redan: dessa TV-apparater fyller i pixlar baserade på matematiska formler som statistiskt sett mest sannolikt ger exakta bilder, men har inget sätt att tolka hur de tematiskt ska se ut baserat på vad som faktiskt finns på skärmen.

Så efter att ha förklarat hur dessa algoritmer konsekvent kom till korta, förklarade Samsungs team hur deras AI övervinner dessa brister.

Samsungs hemlighet: Maskininlärning, objektigenkänning och filter

Samsungs hemliga vapen är en teknik som kallas maskininlärning superupplösning (MLSR). Detta AI-drivna system tar en videoström med lägre upplösning och uppskalar den så att den passar upplösningen på större skärmar med ett högre PPI-förhållande. Det är motsvarigheten till den gamla löjliga TV-tropen av datavetare som zooma in och "förbättra" en oskarp bild med ett tangenttryck, med skillnaden att det görs automatiskt och nästan omedelbart.

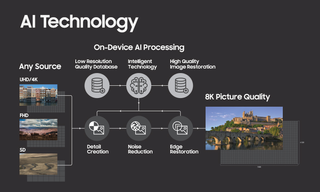

Samsungs representanter förklarade hur de analyserade en enorm mängd videoinnehåll från olika källor - högkvalitativa YouTube-strömmar, DVD-skivor och Blu-Rays, filmer och sportevenemang - och skapade två bilddatabaser, en för skärmdumpar av låg kvalitet och en för skärmdumpar av hög kvalitet.

Sedan fick den utbilda sin AI för att slutföra en process som kallas ”omvänd nedbrytning” av AI-industrin. Först tar du bilder med hög upplösning och nedgraderar dem till lägre upplösningar och spårar vilka visuella data som går förlorade. Då måste du vända processen och utbilda din AI för att fylla i de saknade data från bilder med låg upplösning så att de speglar bilder med hög upplösning.

Samsungs team kallar denna process för en "formel". Dess 8K-processorer innehåller en formelbank med en databas med formler för olika objekt, till exempel ett äpple eller bokstaven "A". När processorn känner igen ett suddigt äpple i en skådespelares hand kommer det att återställa äpplekanterna, reparera eventuella komprimeringsföremål och se till att tomma pixlar får rätt röd nyans baserat på hur äpplen verkligen ser ut, inte baserat på vaga statistiska algoritmer . Dessutom, tillsammans med specifik objektåterställning, kommer AI att justera din ström baserat på vad du tittar på.

Enligt Samsung har det dussintals olika "filter" som ändrar hur mycket detaljskapande, brusreducering och kantåterställning behövs för en given ström, baserat på om du tittar på en specifik sport, filmgenre eller filmtyp.

Uppskalning i aktion

TV:n till vänster är en Samsung 4K-TV utan AI-uppskalning; TV:n till höger är en 8K. Till vänster kan du upptäcka blockade greener och dåliga övergångar från ljusa till mörka sektioner runt skådespelaren.

Börsinformation på en 4K-skärm.

Jämför den här skärmen med den föregående. Större rubriker är läsbara på båda, men bara denna 8K-skärm gör den mindre texten läsbar. Delvis på grund av bättre ljusstyrka, men också på grund av bättre kantåterställning.

En annan 8K-återställd skärm med text

Jämfört med föregående skärm är all text som inte är rubriken mycket svårare att läsa här.

Kantrestaureringen som visas i bildspelet ovan - en galen textmängd att återställa i realtid - är inte ens den svåraste uppgiften för AI, enligt Samsungs ingenjörer. Istället förblir en svår utmaning att replikera ett objekts korrekta strukturer i realtid. De måste se till att processorn förstärker utseendet på föremål utan att de får ett konstgjort utseende.

Vad processorn inte kommer att göra (enligt Samsung) är att kategorisera ett objekt fel. "Det kommer inte att göra ett äpple till en tomat", försäkrade en ingenjör oss, men utan att ge några detaljer. Mycket troligt är processorn utbildad för att undvika drastiska förändringar om den inte känner igen vad ett objekt är.

Du kommer inte heller se AI förändra filmens ”instruktionsinriktning”, som Samsungs team uttryckte det. Så om en regissör använder bokeh-effekten, förblir den suddiga bakgrunden suddig, medan förgrunden blir uppringd till 8K-skärpa.

De hävdade också att de inte specifikt analyserar mer populära strömmar för sin kategorisering av objekt, och siktade mer på allmän mängd och mångfald av innehåll. Så inget ord om de har en "drake" eller "direwolf"-formel för dina maratonsittningar med Game of Thrones.

Nya Samsung 8K (och 4K) TV-apparater levereras med den senaste formelbanken installerad, och sedan läggs till nya objektdata via firmware-uppdateringar som du måste godkänna. Samsung säger att de kommer att fortsätta att analysera nya visuella strömmar för att utöka sitt objektbibliotek, men att man gör det lokalt på Samsung-servrar; man analyserar inte data från människors TV-apparater.

Hur många objektformler har Samsung samlat från sin oändliga strömanalys? En av dess ingenjörer gav en mellan-tummen-och-pekfingret-siffra som lät imponerande hög, vilket tyder på att processorn rimligtvis känner igen ett stort antal objekt på skärmen. Men en PR-representant avbröt och bad att vi inte skulle skriva ut siffran och säga att de hellre skulle vilja att konsumenterna fokuserar på hur väl Samsungs MLSR fungerar än på godtyckliga siffror.

AI-uppskalning: det nya normala?

Samsung är inte den enda TV-tillverkaren som för närvarande använder konstgjord intelligens och bildåterställning för sina TV-apparater.

Sonys 4K-annonssida går in på överväldigande detaljer om sina AI-bildbehandlingslösningar. Dess nya 4K-TV-apparater innehåller processorer med en "dubbel databas" med "tiotusentals" bildreferenser som "dynamiskt förbättrar pixlar i realtid".

LG meddelade också inför CES 2019 att dess nya a9 Gen 2 TV-chip skulle innehålla bildbehandling och maskininlärning för att förbättra brusreducering och ljusstyrka - delvis genom att analysera källan och typen av media och justera dess algoritm i enlighet därmed.

Utöver AI-elementen verkar det dock som om dessa TV-processorer fortfarande är beroende av automatiserade algoritmer. När vi tidigare intervjuade Gavin McCarron, chef för teknisk marknadsföring och produktplanering på Sony Europe, om AI-bildbehandlingen i Sony TV:er, hade han detta att säga:

"När du uppskalar från Full HD till 4K finns det mycket gissningar, och vad vi försöker göra är att ta bort så mycket av gissningen som möjligt. [Vår processor] tittar inte bara på pixeln i isolering, den ser på pixlarna runt om, och på varje diagonal, och den kommer också att slå upp pixlarna över flera ramar för att ge en konsekvens i bildkvaliteten."

Sony, tillsammans med LG och Samsung, använder mycket troligt någon form av bilateral eller bicubisk algoritm som sitt grunduppgraderingssystem. Sedan analyserar de nästan 4K-innehållet och bestämmer vilka pixlar som ska kompletteras med bildbehandling och vilka som ska tas bort som brus.

I den meningen är de flesta tv-tillverkare relativt nära varandra i AI-uppskalningstävlingen. Undantaget är Samsung, som använder samma teknik men fyller i fyra gånger antalet pixlar som saknas för att passa en 8K-skärm. Vi måste vänta och se om andra tillverkares AI-ansträngningar gör att de också hoppar in på 8K-marknaden.

- Vilken TV kan du köpa med Samsungs 8K-uppskalningsteknologi? Kolla in

- Samsung Q950R 8K QLED TV

Michael Hicks began his freelance writing career with TechRadar in 2016, covering emerging tech like VR and self-driving cars. Nowadays, he works as a staff editor for Android Central, but still writes occasional TR reviews, how-tos and explainers on phones, tablets, smart home devices, and other tech.