Google är på väg att bli ännu bättre på att förstå dina sökningar

Den största uppdateringen på 5 år

Google meddelade att de släpper en stor uppdatering hos sin sökmotor, vilket betyder att den bör bli bättre på att förstå dina sökningar i sin kontext – istället för att endast matcha ihop nyckelord kan den faktiskt lista ut vad du försöker att säga.

Tack vare en ny maskinlärningsprocess, säger Google, så kommer du inte att behöva trycka in nyckelord i dina sökningar för att få rätt resultat att visa sig först. Istället kommer du kunna vara mer naturlig.

"Särskilt för längre, mer talspråkliga frågor eller sökningar där prepositioner som "för" och "till" har en betydelse för innebörden. Sökningen kommer att förstå hela kontexten av orden i din fråga", säger Googles Pandu Nayak.

- Google lanserade precis Pixelbook Go

- Androids anpassningar kan skada den

- Facebook börjar med nyheter

"Det spelar ingen roll vad du letar efter eller vilket språk du talar, vi hoppas att du kommer att kunna släppa några av dina nyckelordssökningar och istället söka på ett sätt som känns mer naturligt för dig," tillägger Nayak.

Sök och du skall finna

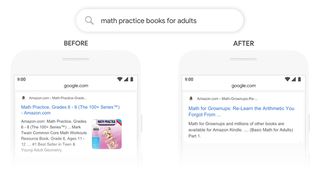

Låt oss ge dig några av Googles egna exempel för att visa hur förändringen fungerar. Förut under en sökning som "2019 brasiliansk resenär till usa behöver ett visum" så skulle Google ignorera "till" eftersom det är för vanligt, och därmed visa resultat för amerikanska medborgare som ska till Brasilien. Nu känner den igen "till" och visar resultat för resenärer från Brasilien till USA.

Under en sökning som "står hudterapeuter massor på jobbet" skulle Google tidigare inte förstå kontexten för "står" (till exempel kan det relateras till hur de står ut med de fysiska kraven på jobbet). Med den nya uppdateringen så förstår den vad du försöker säga.

Dessa förbättringar är tillräckligt betydande för att Google ska kalla dem för deras viktigaste sökningsuppdateringar på fem år. I början kommer denna nya teknologi endast att tillsättas för sökningar på amerikansk engelska, men kommer att expanderas till fler språk över tiden.

Få daglig insikt, inspiration och erbjudanden i din inkorg

Registrera dig för senaste nyheter, recensioner, åsikter, toppteknologiska erbjudanden och mer.

För en mer detaljerad titt på de naturliga nätverksinnovationerna som ligger till grund för denna förbättring – särskilt en träningsmodell som kallas för Bidirectional Encoder Representations (SV: dubbelriktad kodare representationer) från Transformers eller BERT – gå över till Googles blogginlägg om förändringarna.

Dave is a freelance tech journalist who has been writing about gadgets, apps and the web for more than two decades. Based out of Stockport, England, on TechRadar you'll find him covering news, features and reviews, particularly for phones, tablets and wearables. Working to ensure our breaking news coverage is the best in the business over weekends, David also has bylines at Gizmodo, T3, PopSci and a few other places besides, as well as being many years editing the likes of PC Explorer and The Hardware Handbook.